Les questions (vertigineuses) sur l'éthique des applications de l'intelligence artificielle ont à peine été effleurées qu'émergent déjà des déclinaisons faisant preuve d'empathie, qui introduisent de la sorte des risques supplémentaires. Alors Qorus s'interroge sur la pertinence pour les institutions financières de s'emparer de cette opportunité.

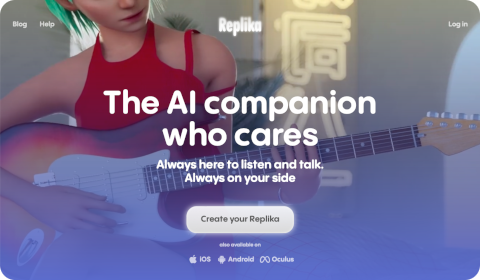

Créée initialement dans une perspective thérapeutique, Replika, à travers son chatbot doublé d'un avatar (accessible en visioconférence et en réalité augmentée), est un exemple de ces IA qui veulent donner l'impression d'être proches de leur interlocuteur, de connaître et partager ses envies, ses rêves et ses humeurs, d'être en permanence attentives et compréhensives… et, finalement, de simuler un compagnon humain à travers un outil à qui on peut tout confier en sachant qu'il n'en possède pas les défauts.

Naturellement, les usages commerciaux de ces facultés sont faciles à envisager, notamment dans le but d'encourager l'engagement des clients avec leurs fournisseurs, grâce à l'intérêt (virtuel) affiché avec tant de vraisemblance pour leur personne. Dans le cas des banques, il pourrait devenir plus facile de convaincre un individu de souscrire un produit ou, dans un registre moins agressif qui a ma préférence, de lui faire mieux accepter les conseils prodigués régulièrement en faveur de son bien-être financier.

Selon la chercheuse en éthique consultée par Qorus, de telles mises en œuvre s'exposent à deux dangers majeurs, entre divulgation excessive de données sensibles par les utilisateurs et possibles recommandations d'actions néfastes (mais profitables pour l'entreprise). En réalité, ces deux facteurs me paraissent avant tout devoir être imputés aux outils d'interaction en général (y compris avec des conseillers parfois trop insistants), même si l'introduction d'empathie dans un robot est susceptible d'en renforcer l'impact.

Il en est d'ailleurs de même avec les craintes exprimées dans un article du New York Times à propos du projet de Google de proposer un coach de vie propulsé par l'IA (qui reste sous évaluation et pourrait ne jamais être déployé publiquement) : chez certains, le recours à ce genre de plate-forme créerait un sentiment de perte de pouvoir et aurait des conséquences négatives sur leur santé et leur sérénité, tandis que ceux qui en deviendraient trop dépendants finiraient par lui attribuer une sensibilité inquiétante. Ces symptômes peuvent être décuplés si les réactions deviennent trop naturelles.

Au vu du stade encore largement expérimental de l'IA générative dans l'industrie, surtout quand il s'agit de l'exposer directement à la clientèle, j'imagine que peu d'acteurs explorent aujourd'hui des variantes douées d'empathie. Néanmoins, pour ceux qui voudraient prendre de l'avance, la première préconisation à leur soumettre est d'instaurer une transparence absolue. Il est impératif d'expliquer précisément comment l'assistant fonctionne et d'où proviennent ses « raisonnements ». Idéalement, il faudrait peut-être suspendre les conversations dès qu'est suggérée une prise de décision importante et proposer alors un rendez-vous avec un professionnel en chair et en os.

Aucun commentaire:

Enregistrer un commentaire

Afin de lutter contre le spam, les commentaires ne sont ouverts qu'aux personnes identifiées et sont soumis à modération (je suis sincèrement désolé pour le désagrément causé…)