Forrester Reasearch a publié l'édition 2010 de son "Social Technographics", un rapport qui analyse les formes d'adoption du web social par les internautes du monde entier.

Les résultats montrent pour la première fois un renversement de tendance : alors que la participation aux réseaux sociaux reste en forte hausse, la proportion des "créateurs" de contenus (rédacteurs de blogs, producteurs de vidéos, "partageurs" de photos...), comme celle des "critiques" (ceux qui commentent sur les blogs, par exemple), est stable, voire même en légère baisse selon les régions.

A l'opposé, Forrester a introduit dans son échelle des modes de participation une nouvelle catégorie de "conversationnalistes", qui devient directement l'une des plus importantes (elle regroupe environ 1/3 des internautes en Europe). Cette catégorie décrit les utilisateurs de Twitter et autres adeptes de la mise à jour de leur statut ou du partage de leurs idées et réflexions en quelques lignes.

Même si les analystes ne le mentionnent pas, il me semble évident que le croisement de ces deux tendances démontre que le "micro-blogging" (à la Twitter) est en train de cannibaliser la production de contenus. Et il serait dommage que ce phénomène s'amplifie car il pourrait conduire à une diminution du nombre des idées nouvelles et des opinions en circulation, qui constituent une des principales richesses du web social.

jeudi 30 septembre 2010

mardi 28 septembre 2010

Mes 10 centimes sur le BlackBerry PlayBook

Research In Motion (RIM), le fabricant canadien des smartphones BlackBerry, vient donc d'annoncer en fanfare sa future tablette tactile "PlayBook". Le communiqué de presse est sans équivoque et vise directement l'iPad d'Apple en mettant par exemple l'accent sur son système "vraiment" multi-tâches et la présence de deux caméras... Le constructeur reste cependant fidèle à sa cible privilégiée des entreprises, l'appareil ayant été conçu avec des dirigeants pour s'adapter au mieux à leurs besoins.

Sans entrer dans les détails, le PlayBook est un appareil petit et léger (400 g), embarquant un processeur ultra-puissant (il n'est malheureusement pas question de son autonomie) et destiné à fonctionner en symbiose avec un (smartphone) BlackBerry. Ainsi, la tablette est essentiellement conçue pour exploiter, via une connexion bluetooth, les contenus stockés sur le BlackBerry ou accessibles depuis celui-ci (mails, tâches, agenda, documents de l'entreprise...). Cette approche facilite la sécurisation de l'appareil puisqu'aucune donnée n'y est stockée et permet à RIM d'annoncer une compatibilité directe avec ses serveurs d'entreprise (BES), les échanges étant réalisés à travers le smartphone qui y est déjà connecté.

La tablette embarque un browser évolué, supportant Flash et HTML 5 et ses deux caméras permettent d'envisager des applications de visio-conférence. Pour ces deux fonctions, il faudra disposer d'une connexion WiFi ou, là encore, utiliser la connexion 3G du smartphone.

L'annonce comporte une mauvaise nouvelle pour les développeurs. En effet, le PlayBook est équipé d'un nouveau système d'exploitation (le "BlackBerry Tablet OS"), issu du rachat récent de QNX par RIM, ce qui va fragmenter encore un peu plus le marché des OS mobiles et disperser les efforts des créateurs d'applications. Il est précisé que les applications existantes pour BlackBerry OS seront compatibles mais l'utilisateur aura certainement tendance à utiliser les applications conçues pour smartphone sur le Blackberry qu'il doit également posséder.

Et ce n'est pas la nouvelle plate-forme "WebWorks" de développement web (et une de plus !), annoncée conjointement, qui va faciliter le choix...

Malgré ses arguments destinés à séduire les décideurs, la stratégie adoptée par RIM pour sa tablette me laisse perplexe, la quasi-nécessité de lui adjoindre un smartphone constituant pour moi un frein à son adoption. Par ailleurs, rien ne prouve que le nouveau système séduira les développeurs d'application qui ont déjà fort à faire avec l'iPad et la vague prochaine des tablettes sous Android. L'écosystème des applications tierces étant aujourd'hui un des principaux facteurs de succès d'une plate-forme mobile, RIM fait là un pari risqué.

Tout cela rappelle d'ailleurs étrangement le Foleo de Palm, annoncé en 2007 et jamais produit, qui avait été conçu comme un compagnon des smartphones Treo et qui n'a pas survécu aux critiques dont il a fait l'objet (les mêmes que j'adresse aujourd'hui au PlayBook).

En conclusion, RIM commet probablement une erreur en ignorant la tendance à la "consumérisation" de la technologie et en prolongeant sa stratégie vers les entreprises, où la domination de ses smartphones commence à s'éroder sérieusement. Quand les cadres rangent dans un tiroir le BlackBerry fourni par leur employeur pour utiliser leur iPhone personnel, le PlayBook a-t-il une chance de ne pas subir le même sort face aux iPads ? Difficile d'y croire...

Sans entrer dans les détails, le PlayBook est un appareil petit et léger (400 g), embarquant un processeur ultra-puissant (il n'est malheureusement pas question de son autonomie) et destiné à fonctionner en symbiose avec un (smartphone) BlackBerry. Ainsi, la tablette est essentiellement conçue pour exploiter, via une connexion bluetooth, les contenus stockés sur le BlackBerry ou accessibles depuis celui-ci (mails, tâches, agenda, documents de l'entreprise...). Cette approche facilite la sécurisation de l'appareil puisqu'aucune donnée n'y est stockée et permet à RIM d'annoncer une compatibilité directe avec ses serveurs d'entreprise (BES), les échanges étant réalisés à travers le smartphone qui y est déjà connecté.

La tablette embarque un browser évolué, supportant Flash et HTML 5 et ses deux caméras permettent d'envisager des applications de visio-conférence. Pour ces deux fonctions, il faudra disposer d'une connexion WiFi ou, là encore, utiliser la connexion 3G du smartphone.

L'annonce comporte une mauvaise nouvelle pour les développeurs. En effet, le PlayBook est équipé d'un nouveau système d'exploitation (le "BlackBerry Tablet OS"), issu du rachat récent de QNX par RIM, ce qui va fragmenter encore un peu plus le marché des OS mobiles et disperser les efforts des créateurs d'applications. Il est précisé que les applications existantes pour BlackBerry OS seront compatibles mais l'utilisateur aura certainement tendance à utiliser les applications conçues pour smartphone sur le Blackberry qu'il doit également posséder.

Et ce n'est pas la nouvelle plate-forme "WebWorks" de développement web (et une de plus !), annoncée conjointement, qui va faciliter le choix...

Malgré ses arguments destinés à séduire les décideurs, la stratégie adoptée par RIM pour sa tablette me laisse perplexe, la quasi-nécessité de lui adjoindre un smartphone constituant pour moi un frein à son adoption. Par ailleurs, rien ne prouve que le nouveau système séduira les développeurs d'application qui ont déjà fort à faire avec l'iPad et la vague prochaine des tablettes sous Android. L'écosystème des applications tierces étant aujourd'hui un des principaux facteurs de succès d'une plate-forme mobile, RIM fait là un pari risqué.

Tout cela rappelle d'ailleurs étrangement le Foleo de Palm, annoncé en 2007 et jamais produit, qui avait été conçu comme un compagnon des smartphones Treo et qui n'a pas survécu aux critiques dont il a fait l'objet (les mêmes que j'adresse aujourd'hui au PlayBook).

En conclusion, RIM commet probablement une erreur en ignorant la tendance à la "consumérisation" de la technologie et en prolongeant sa stratégie vers les entreprises, où la domination de ses smartphones commence à s'éroder sérieusement. Quand les cadres rangent dans un tiroir le BlackBerry fourni par leur employeur pour utiliser leur iPhone personnel, le PlayBook a-t-il une chance de ne pas subir le même sort face aux iPads ? Difficile d'y croire...

Première attaque sur l'authentification à deux facteurs via SMS

Alors que les systèmes de sécurité se renforcent lentement sur le web, les cybercriminels font évoluer aussi rapidement les techniques qu'ils développent pour les contourner.

L'un des mécanismes de protection "avancée" qui se développe actuellement est l'authentification à deux facteurs par SMS : lors de l'authentification, un mot de passe à usage unique, transmis par SMS, est demandé en complément des identifiants et codes secrets habituels. Vous avez peut-être déjà rencontré ce système sur le site web de votre banque ou sur quelques sites de commerce en ligne, avec des initiatives telles que 3DSecure de Visa.

Or un laboratoire de sécurité espagnol, S21sec, vient de découvrir la première attaque ciblant ces systèmes dans leur coeur. Le scénario est relativement complexe : un cheval de Troie classique (ZeuS en l'occurence) prend le contrôle du PC de la victime (interceptant alors facilement les identifiants et mots de passe "traditionnels") et l'incite à fournir des informations sur son mobile (en "maquillant" un site de confiance), un SMS est ensuite envoyé sur le mobile, demandant l'installation d'un certificat de sécurité, qui est en réalité une application malveillante dont le rôle sera d'intercepter les SMS contenant les codes à usage unique et les retransmettre à l'attaquant, donnant ainsi à celui-ci un contrôle total sur les accès sécurisés aux sites de banque en ligne ou de e-commerce.

Le risque induit par cette attaque reste encore assez faible car elle requiert une certaine crédulité de la part de la victime (qui reste malheureusement tout à fait plausible). Mais cette première démontre la détermination des cybercriminels à ne pas se laisser distancer par les progrès des techniques de sécurisation. Elle doit donc constituer une alerte pour les responsables de la sécurité et les inciter à accélérer le déploiement de systèmes toujours plus élaborés pour protéger leurs sites web. Et il ne faudra pas oublier de redoubler les efforts pour sensibiliser et éduquer les consommateurs sur les risques qu'ils encourent...

L'un des mécanismes de protection "avancée" qui se développe actuellement est l'authentification à deux facteurs par SMS : lors de l'authentification, un mot de passe à usage unique, transmis par SMS, est demandé en complément des identifiants et codes secrets habituels. Vous avez peut-être déjà rencontré ce système sur le site web de votre banque ou sur quelques sites de commerce en ligne, avec des initiatives telles que 3DSecure de Visa.

Or un laboratoire de sécurité espagnol, S21sec, vient de découvrir la première attaque ciblant ces systèmes dans leur coeur. Le scénario est relativement complexe : un cheval de Troie classique (ZeuS en l'occurence) prend le contrôle du PC de la victime (interceptant alors facilement les identifiants et mots de passe "traditionnels") et l'incite à fournir des informations sur son mobile (en "maquillant" un site de confiance), un SMS est ensuite envoyé sur le mobile, demandant l'installation d'un certificat de sécurité, qui est en réalité une application malveillante dont le rôle sera d'intercepter les SMS contenant les codes à usage unique et les retransmettre à l'attaquant, donnant ainsi à celui-ci un contrôle total sur les accès sécurisés aux sites de banque en ligne ou de e-commerce.

Le risque induit par cette attaque reste encore assez faible car elle requiert une certaine crédulité de la part de la victime (qui reste malheureusement tout à fait plausible). Mais cette première démontre la détermination des cybercriminels à ne pas se laisser distancer par les progrès des techniques de sécurisation. Elle doit donc constituer une alerte pour les responsables de la sécurité et les inciter à accélérer le déploiement de systèmes toujours plus élaborés pour protéger leurs sites web. Et il ne faudra pas oublier de redoubler les efforts pour sensibiliser et éduquer les consommateurs sur les risques qu'ils encourent...

lundi 27 septembre 2010

Sensibiliser les cadres d'entreprise à la technologie

La technologie est souvent perçue comme un simple outil, voire comme un mal nécessaire, par les dirigeants et autres cadres de l'entreprise, en dehors de la DSI. Pourtant, elle peut devenir une arme concurrentielle, lorsque ses possibilités sont bien comprises et mises en application avec discernement.

C'est la raison pour laquelle la DSI et le département marketing du laboratoire de cosmétiques Oriflame ont remis un iPad à chacun des 450 cadres invités à son séminaire annuel. La tablette était chargée avec deux applications développées pour l'occasion (l'agenda du séminaire et le catalogue des produits de l'entreprise). Et, si l'on en croit les queues devant le stand d'information dédié, l'opération a été un succès !

Aujourd'hui, l'informatique n'est plus seulement un moyen d'améliorer l'efficacité des processus et la productivité des employés de l'entreprise. De plus en plus souvent, les innovations technologiques sont à la source de nouveaux produits ou services (surtout dans les institutions financières) et la perméabilité entre le monde de la DSI et celui des "métiers" est un facteur d'accélération important de l'émergence de nouvelles idées.

Malheureusement, les directeurs informatiques, en plus de porter (généralement) une image de centre de coûts, ont des difficultés à établir la communication avec leurs pairs dans l'entreprise, et, par voie de conséquence, à être considérés (aussi) comme sources de valeur pour le business. L'exemple d'Oriflame est une approche extrême, ne serait-ce que par son coût, mais certainement efficace, pour amener les cadres à découvrir la technologie sous un nouvel angle et rechercher le dialogue avec leur DSI.

Concluons ce constat par une injonction : DSI, développez votre communication ! Pour l'anecdote, il s'agit d'un message que j'ai déjà entendu dans la bouche du DSI d'une grande entreprise française...

Référence : Gartner Blogs (Mark Raskino)

C'est la raison pour laquelle la DSI et le département marketing du laboratoire de cosmétiques Oriflame ont remis un iPad à chacun des 450 cadres invités à son séminaire annuel. La tablette était chargée avec deux applications développées pour l'occasion (l'agenda du séminaire et le catalogue des produits de l'entreprise). Et, si l'on en croit les queues devant le stand d'information dédié, l'opération a été un succès !

Aujourd'hui, l'informatique n'est plus seulement un moyen d'améliorer l'efficacité des processus et la productivité des employés de l'entreprise. De plus en plus souvent, les innovations technologiques sont à la source de nouveaux produits ou services (surtout dans les institutions financières) et la perméabilité entre le monde de la DSI et celui des "métiers" est un facteur d'accélération important de l'émergence de nouvelles idées.

Malheureusement, les directeurs informatiques, en plus de porter (généralement) une image de centre de coûts, ont des difficultés à établir la communication avec leurs pairs dans l'entreprise, et, par voie de conséquence, à être considérés (aussi) comme sources de valeur pour le business. L'exemple d'Oriflame est une approche extrême, ne serait-ce que par son coût, mais certainement efficace, pour amener les cadres à découvrir la technologie sous un nouvel angle et rechercher le dialogue avec leur DSI.

Concluons ce constat par une injonction : DSI, développez votre communication ! Pour l'anecdote, il s'agit d'un message que j'ai déjà entendu dans la bouche du DSI d'une grande entreprise française...

Référence : Gartner Blogs (Mark Raskino)

dimanche 26 septembre 2010

A voir ailleurs : Scrum en 8 minutes

Axosoft, éditeur du logiciel de gestion de projet "OnTime", propose une courte vidéo de présentation de Scrum, la méthode agile la plus plus populaire dont elle s'est fait une spécialité.

Cet exposé intéressera non seulement les personnes impliquées dans les projets informatiques mais également leurs "clients", qui souhaitent toujours voir les applications qu'ils demandent livrées plus rapidement et sans défaut. Et même si vous n'envisagez pas de généraliser la méthode Scrum dans votre organisation, vous y trouverez des idées pour améliorer l'efficacité de vos processus de création de logiciels.

En 8 minutes, la vidéo aborde les 3 piliers de Scrum :

Cet exposé intéressera non seulement les personnes impliquées dans les projets informatiques mais également leurs "clients", qui souhaitent toujours voir les applications qu'ils demandent livrées plus rapidement et sans défaut. Et même si vous n'envisagez pas de généraliser la méthode Scrum dans votre organisation, vous y trouverez des idées pour améliorer l'efficacité de vos processus de création de logiciels.

En 8 minutes, la vidéo aborde les 3 piliers de Scrum :

- Les acteurs et leurs rôles respectifs dont les principaux sont le propriétaire du produit ("product owner"), qui représente le "client" et détermine le choix des fonctions à inclure dans le produit à livrer en en fixant les priorités, et le "scrum master" (le chef de projet), qui donne les moyens à toutes les parties prenantes de remplir leur rôle et assure le suivi du projet.

- Le découpage du projet qui commence par la formalisation du "backlog" du produit, qui englobe toutes les fonctions envisagées (rêvées) dans le logiciel final. Le propriétaire du produit en extrait les fonctions nécessaires pour livrer une version utilisable du produit, ce qui conduit à un "backlog" de version, dans lequel chaque fonction est associée à une priorité et à une estimation du temps nécessaire à sa réalisation.

Ce backlog est ensuite lui-même découpé en au moins 4 "sprints" (selon les priorités définies) dont l'objectif est de livrer intégralement les fonctions qui les composent en un temps court (de 3 à 30 jours). Un exemple de découpage : un "sprint" pour les fonctions essentielles, un pour les fonctions importantes, un pour les fonctions secondaires et un "sprint" de stabilisation (qui sera consacré à l'élimination des anomalies résiduelles).

- Les techniques associées, dont le "scrum meeting" quotidien (réunion courte, de moins d'un quart d'heure), qui permet au "scrum master" de suivre l'évolution du projet et identifier les risques au plus tôt, et le "burndown", graphique de suivi au jour le jour de l'avancement du projet, rendu possible par les estimations initiales de charges associées à chaque fonction (donc à chaque "sprint"), la connaissance de la productivité moyenne de l'équipe et les retours de l'équipe lors des "scrum meetings".

Mes excuses pour les termes anglais qui émaillent ce texte, je n'ai pas jugé bon de traduire les désignations consacrées de la méthode...

BNP Paribas récompense ses innovateurs

Comme chaque année, BNP Paribas a décerné ses prix de l'innovation récompensant les idées et initiatives developpées dans le groupe et "apportant un progrès réel à moyen et long terme à l'entreprise et son écosystème". Pour cette édition, 24 lauréats sont distingués parmi 217 dossiers candidats. La communication officielle de la banque ne fournit pas beaucoup de détails mais laissons donc notre imagination vagabonder sur une sélection d'innovations à connotation technologique (et que j'estime intéressantes)...

Réseaux sociaux et web 2.0 (banque de détail en France)

La création d'un profil sur Facebook et sur Twitter s'incrit pour BNP Paribas dans sa stratégie d'être la première banque en ligne en France en 2012. Ses plus de 100 000 fans sur Facebook (qui serait un record mondial pour une banque, selon le communiqué) semblent démontrer la pertinence de son approche.

Espérons que ces iniatives ne soient bientôt plus considérées comme innovantes et deviennent la norme, Facebook étant ici classiquement utilisé comme un canal principalement marketing et Twitter étant plutôt orienté sur le support aux clients.

En tout état de cause, le succès de BNP Paribas sur Facebook (et, dans une moindre mesure, sur Twitter, où la banque a 1750 "suiveurs"), démontre une vraie capacité d'animation dont d'autres entreprises feraient bien de s'inspirer.

Souscription de cartes bancaires sur Blackberry (Fortis Turkey et TEB)

Les conseillers des filiales turques de BNP Paribas disposent depuis avril 2009 d'une application sur Blackberry leur permettant d'enregistrer les commandes de cartes bancaires de leur client, en tout lieu et à tout moment, par exemple lors d'un rendez-vous chez le client.

Cette idée, pourtant simple à mettre en oeuvre, me semble être une première. Il ne reste plus à la banque qu'à prolonger son effort pour offrir la souscription d'autres produits sur le même mode et, peut-être, le déployer sur iPad qui pourrait devenir le support idéal pour ce type d'approche.

K2pédia (BNP Paribas Assurance)

K2pédia est un "simple" dictionnaire métier multilingue, entièrement géré par ses utilisateurs, sans contrôle central et sans restriction, à la manière de l'encyclopédie en ligne wikipedia.

Là encore, la dimension innovante peut paraître modeste au premier, puisque wikipedia et les wikis en général sont considérés comme des outils mûrs et maîtrisés. Pourtant, les entreprises restent extrêmement réticentes à laisser l'entière liberté à leurs collaborateurs de participer à des plates-formes internes de collaboration, en particulier sur des référentiels parfois sensibles (tels que les dictionnaires bancaires). L'exemple de BNP Paribas Assurance prouve (une fois de plus) que les craintes de dérive et d'anarchie sont infondées et que le modèle de l'encyclopédie collaborative ouverte est tout à fait transposable en entreprise, pour le plus grand bien de la connaissance et de son partage.

Plate-forme Share to Lead (RH Groupe)

Cette plate-forme collaborative accompagne les séminaires des collaborateurs "à haut potentiel" : avant, en favorisant la prise de contact, pendant, pour échanger sur les travaux du groupe, et après, pour "cultiver" son réseau interne.

L'objectif affiché suggèrerait l'utilisation d'une plate-forme de réseau social. La communication de BNP Paribas a peut-être voulu éviter d'utiliser cette expression "tarte à la crème" mais il serait intéressant de savoir si la solution mise en place est un outil collaboratif classique ou plus "2.0", et d'en connaître le succès.

Quoiqu'il en soit, développer la collaboration dans des communautés variées, formelles ou non, au sein de l'entreprise est encore trop souvent l'exception. La mise en place d'une plate-forme de dialogue autour d'événements ou autres séminaires est un des cas où la valeur des échanges est rapidement visible, pour un effort de mise en oeuvre minime.

Crédit multi-pays via PayPal (BNP Paribas Personal Finance)

Cette offre est déjà connue, combinant le crédit à la consommation (sous forme d'une ligne de crédit virtuelle) et une carte co-brandée avec PayPal.

Alors que de nombreux établissements s'interrogent toujours sur PayPal et les opportunités ou menaces que peuvent représenter le numéro 1 du paiement en ligne, BNP Paribas a résolument décidé de profiter des opportunités et il est certain que la banque peut s'en féliciter, avec une croissance continue du marché qui doit lui profiter largement.

E-Cho-Mmunication (BNP Paribas Securities Services)

Cette solution, présentée comme une première en France, permet de dématérialiser les procédures de vote lors des assemblées générales d'actionnaires d'entreprises clientes de ce service.

Cette dernière innovation de ma sélection m'intrigue : je pense que le vote électronique est désormais largement répandu dans les assemblées générales et je me demande donc ce qu'a pu y ajouter BNP Paribas pour la distinguer. Une dématérialisation des documents préparatoires et/ou de la gestion des pouvoirs, le vote à distance ?

Conclusion

Si les innovations récompensées n'ont rien de révolutionnaire, ces quelques réalisations ont tout de même le mérite de concrétiser des idées que d'autres entreprises ne considèrent que comme sujet de curiosité. La culture de la banque est un ingrédient indispensable à ces efforts, et la triple présence de TEB (la banque de détail de BNP Paribas en Turquie) sur le podium montre que, même dans un grand groupe, toutes ses entités et filiales ne sont pas sur un pied d'égalité dans ce domaine.

Réseaux sociaux et web 2.0 (banque de détail en France)

La création d'un profil sur Facebook et sur Twitter s'incrit pour BNP Paribas dans sa stratégie d'être la première banque en ligne en France en 2012. Ses plus de 100 000 fans sur Facebook (qui serait un record mondial pour une banque, selon le communiqué) semblent démontrer la pertinence de son approche.

Espérons que ces iniatives ne soient bientôt plus considérées comme innovantes et deviennent la norme, Facebook étant ici classiquement utilisé comme un canal principalement marketing et Twitter étant plutôt orienté sur le support aux clients.

En tout état de cause, le succès de BNP Paribas sur Facebook (et, dans une moindre mesure, sur Twitter, où la banque a 1750 "suiveurs"), démontre une vraie capacité d'animation dont d'autres entreprises feraient bien de s'inspirer.

Souscription de cartes bancaires sur Blackberry (Fortis Turkey et TEB)

Les conseillers des filiales turques de BNP Paribas disposent depuis avril 2009 d'une application sur Blackberry leur permettant d'enregistrer les commandes de cartes bancaires de leur client, en tout lieu et à tout moment, par exemple lors d'un rendez-vous chez le client.

Cette idée, pourtant simple à mettre en oeuvre, me semble être une première. Il ne reste plus à la banque qu'à prolonger son effort pour offrir la souscription d'autres produits sur le même mode et, peut-être, le déployer sur iPad qui pourrait devenir le support idéal pour ce type d'approche.

K2pédia (BNP Paribas Assurance)

K2pédia est un "simple" dictionnaire métier multilingue, entièrement géré par ses utilisateurs, sans contrôle central et sans restriction, à la manière de l'encyclopédie en ligne wikipedia.

Là encore, la dimension innovante peut paraître modeste au premier, puisque wikipedia et les wikis en général sont considérés comme des outils mûrs et maîtrisés. Pourtant, les entreprises restent extrêmement réticentes à laisser l'entière liberté à leurs collaborateurs de participer à des plates-formes internes de collaboration, en particulier sur des référentiels parfois sensibles (tels que les dictionnaires bancaires). L'exemple de BNP Paribas Assurance prouve (une fois de plus) que les craintes de dérive et d'anarchie sont infondées et que le modèle de l'encyclopédie collaborative ouverte est tout à fait transposable en entreprise, pour le plus grand bien de la connaissance et de son partage.

Plate-forme Share to Lead (RH Groupe)

Cette plate-forme collaborative accompagne les séminaires des collaborateurs "à haut potentiel" : avant, en favorisant la prise de contact, pendant, pour échanger sur les travaux du groupe, et après, pour "cultiver" son réseau interne.

L'objectif affiché suggèrerait l'utilisation d'une plate-forme de réseau social. La communication de BNP Paribas a peut-être voulu éviter d'utiliser cette expression "tarte à la crème" mais il serait intéressant de savoir si la solution mise en place est un outil collaboratif classique ou plus "2.0", et d'en connaître le succès.

Quoiqu'il en soit, développer la collaboration dans des communautés variées, formelles ou non, au sein de l'entreprise est encore trop souvent l'exception. La mise en place d'une plate-forme de dialogue autour d'événements ou autres séminaires est un des cas où la valeur des échanges est rapidement visible, pour un effort de mise en oeuvre minime.

Crédit multi-pays via PayPal (BNP Paribas Personal Finance)

Cette offre est déjà connue, combinant le crédit à la consommation (sous forme d'une ligne de crédit virtuelle) et une carte co-brandée avec PayPal.

Alors que de nombreux établissements s'interrogent toujours sur PayPal et les opportunités ou menaces que peuvent représenter le numéro 1 du paiement en ligne, BNP Paribas a résolument décidé de profiter des opportunités et il est certain que la banque peut s'en féliciter, avec une croissance continue du marché qui doit lui profiter largement.

E-Cho-Mmunication (BNP Paribas Securities Services)

Cette solution, présentée comme une première en France, permet de dématérialiser les procédures de vote lors des assemblées générales d'actionnaires d'entreprises clientes de ce service.

Cette dernière innovation de ma sélection m'intrigue : je pense que le vote électronique est désormais largement répandu dans les assemblées générales et je me demande donc ce qu'a pu y ajouter BNP Paribas pour la distinguer. Une dématérialisation des documents préparatoires et/ou de la gestion des pouvoirs, le vote à distance ?

Conclusion

Si les innovations récompensées n'ont rien de révolutionnaire, ces quelques réalisations ont tout de même le mérite de concrétiser des idées que d'autres entreprises ne considèrent que comme sujet de curiosité. La culture de la banque est un ingrédient indispensable à ces efforts, et la triple présence de TEB (la banque de détail de BNP Paribas en Turquie) sur le podium montre que, même dans un grand groupe, toutes ses entités et filiales ne sont pas sur un pied d'égalité dans ce domaine.

samedi 25 septembre 2010

Chez Microsoft, le test logiciel est un jeu

Les jeux sérieux ("serious games") ont actuellement le vent en poupe, essentiellement dans le domaine de l'auto-formation, pour lequel l'introduction d'une dimension ludique est un facteur décisif d'adoption et d'implication des "élèves". Cette approche peut également être utile pour d'autres activités, comme l'illustre l'expérience de Microsoft.

Le test des logiciels chez le géant de Redmond est une phase critique de son activité, de laquelle dépend pour une large part le succès ou l'échec de ses produits. Suivant une démarche assez classique, une première série de tests est réalisée par des équipes dédiées, puis les nouvelles applications sont déployées en interne, pour une validation en conditions réelles. Pour les collaborateurs qui servent ainsi de cobayes, l'arrivée d'un logiciel non finalisé est, au mieux, une occasion de profiter de nouvelles fonctions mais peu d'entre eux sont enclins à s'impliquer réellement dans les tests et la recherche des anomalies (activité plutôt rébarbative, a priori). C'est pour développer leur motivation que certains chefs de projet transforment l'expérience en un jeu.

Il n'est pas question ici de simples concours de recherche de bugs mais de véritables jeux, conçus et développés autour de l'application à tester, dont la logique est soigneusement étudiée pour en maximiser l'attrait, de même que les récompenses associées. Microsoft a déjà utilisé cette technique en 5 occasions depuis 2006 et son plus grand succès a été un jeu permettant de valider les traductions de l'interface de Windows 7, qui a attiré 4500 participants.

Il est étonnant que Microsoft n'ait pas étendu son expérience aux phases ultérieures de beta-test (diffusion du logiciel auprès de clients réels, sélectionnés ou non). En effet, bien souvent, les utilisateurs qui installent une version beta sont plus attirés par la nouveauté que par la détection et la remontée des anomalies. L'ajout d'une composante ludique pourrait certainement être au moins aussi profitable que pour les tests internes.

Les jeux sérieux n'ont pas encore montré tout leur potentiel et il reste de multiples domaines où ils pourraient être mis à profit. Google nous offre d'ailleurs un autre exemple avec son "Image Labeler", dans lequel les internautes étiquettent, par équipe de deux et en un temps limité, une série d'images qui leur est soumise, pour enrichir les métadonnées du moteur de recherche...

Référence : blog de TJ Keitt (Forrester)

Note : merci d'éviter les commentaires "faciles" sur la qualité du logiciel selon Microsoft ;-)

Le test des logiciels chez le géant de Redmond est une phase critique de son activité, de laquelle dépend pour une large part le succès ou l'échec de ses produits. Suivant une démarche assez classique, une première série de tests est réalisée par des équipes dédiées, puis les nouvelles applications sont déployées en interne, pour une validation en conditions réelles. Pour les collaborateurs qui servent ainsi de cobayes, l'arrivée d'un logiciel non finalisé est, au mieux, une occasion de profiter de nouvelles fonctions mais peu d'entre eux sont enclins à s'impliquer réellement dans les tests et la recherche des anomalies (activité plutôt rébarbative, a priori). C'est pour développer leur motivation que certains chefs de projet transforment l'expérience en un jeu.

Il n'est pas question ici de simples concours de recherche de bugs mais de véritables jeux, conçus et développés autour de l'application à tester, dont la logique est soigneusement étudiée pour en maximiser l'attrait, de même que les récompenses associées. Microsoft a déjà utilisé cette technique en 5 occasions depuis 2006 et son plus grand succès a été un jeu permettant de valider les traductions de l'interface de Windows 7, qui a attiré 4500 participants.

Il est étonnant que Microsoft n'ait pas étendu son expérience aux phases ultérieures de beta-test (diffusion du logiciel auprès de clients réels, sélectionnés ou non). En effet, bien souvent, les utilisateurs qui installent une version beta sont plus attirés par la nouveauté que par la détection et la remontée des anomalies. L'ajout d'une composante ludique pourrait certainement être au moins aussi profitable que pour les tests internes.

Les jeux sérieux n'ont pas encore montré tout leur potentiel et il reste de multiples domaines où ils pourraient être mis à profit. Google nous offre d'ailleurs un autre exemple avec son "Image Labeler", dans lequel les internautes étiquettent, par équipe de deux et en un temps limité, une série d'images qui leur est soumise, pour enrichir les métadonnées du moteur de recherche...

Référence : blog de TJ Keitt (Forrester)

Note : merci d'éviter les commentaires "faciles" sur la qualité du logiciel selon Microsoft ;-)

Les réseaux sociaux inquiètent les assureurs

L'immense popularité des réseaux sociaux, de plus en plus souvent enrichis d'informations de géolocalisation de leurs utilisateurs, constitue une aubaine pour les cambrioleurs : en croisant les informations publiées sur Twitter, Facebook (et Facebook Places), FourSquare... il peut devenir très facile de détecter et profiter de l'absence des occupants d'un logement.

C'est la raison pour laquelle l'assureur britannique Churchill a publié une mise en garde à destination de ses clients, les incitant à réfléchir avant de signaler publiquement leur localisation sur le web. Et la menace n'est pas que théorique puisque la police anglaise vient d'arrêter un gang utilisateur de Facebook Places, ayant à son actif une cinquantaine de cambriolages.

C'est le même risque qu'avaient voulu illustrer 3 néerlandais en dévoilant PleaseRobMe il y a quelques mois. Leur site web, actuellement inactif, exploitait les services de Twitter et de Foursquare pour montrer comment il était possible de repérer des logements vides à chaque instant. Un exemple typique consiste simplement à rapprocher les "check-ins" (FourSquare) des invités arrivant au domicile d'un utilisateur (donnant ainsi son adresse) du statut de celui-ci (indiquant ses absences).

Churchill n'est pas la seule compagnie s'inquiétant de ces possibles usages des réseaux sociaux et certaines pourraient être amenées à ajuster les primes d'assurance habitation en fonction des profils de leurs clients. Qu'elles pourront facilement découvrir et analyser ... sur les réseaux sociaux !

C'est la raison pour laquelle l'assureur britannique Churchill a publié une mise en garde à destination de ses clients, les incitant à réfléchir avant de signaler publiquement leur localisation sur le web. Et la menace n'est pas que théorique puisque la police anglaise vient d'arrêter un gang utilisateur de Facebook Places, ayant à son actif une cinquantaine de cambriolages.

C'est le même risque qu'avaient voulu illustrer 3 néerlandais en dévoilant PleaseRobMe il y a quelques mois. Leur site web, actuellement inactif, exploitait les services de Twitter et de Foursquare pour montrer comment il était possible de repérer des logements vides à chaque instant. Un exemple typique consiste simplement à rapprocher les "check-ins" (FourSquare) des invités arrivant au domicile d'un utilisateur (donnant ainsi son adresse) du statut de celui-ci (indiquant ses absences).

Churchill n'est pas la seule compagnie s'inquiétant de ces possibles usages des réseaux sociaux et certaines pourraient être amenées à ajuster les primes d'assurance habitation en fonction des profils de leurs clients. Qu'elles pourront facilement découvrir et analyser ... sur les réseaux sociaux !

La sécurité du logicel reste médiocre

Veracode, qui propose des services en "cloud" de tests de sécurité, publie la deuxième édition de son rapport de la sécurité des logiciels, issue de son analyse de 2900 applications. Et les résultats ne sont pas très rassurants...

Ainsi, 43% seulement de l'ensemble des applications bénéficient d'un diagnostic de sécurité "acceptable" lors de leur première soumission et en prenant en compte leur criticité. Les applications web (y compris en "cloud"), qui sont heureusement les plus souvent testées, sont aussi les plus sensibles puisque 80% d'entre elles ne sont pas considérés comme suffisamment sécurisées pour passer un audit PCI (Payment Card Industry). Un autre axe d'analyse démontre par ailleurs que le "code tiers" (les composants externes, libres ou non, intégrés dans des solutions globales) est une source importante de failles de sécurité, avec 81% d'échec aux tests.

Et alors qu'on aurait pu espérer que les banques, compagnies d'assurance et autres institutions financières, plus sensibles à la sécurité, soient mieux placées, il n'en est rien : leurs résultats se situent au niveau de la moyenne générale.

La seule note positive du rapport de Veracode est que la correction des failles est de plus en plus rapide, ce qui montre que la maîtrise des exigences de sécurité progresse parmi les développeurs, aidés en cela par des outils plus perfectionnés. Mais la sensibilisation et la formation des professionnels, ainsi que la prise en compte de la sécurité tout au long des processus de développement (de la conception aux tests), méritent encore de gros efforts pour éviter des attaques qui peuvent devenir catastrophiques pour les entreprises.

Ainsi, 43% seulement de l'ensemble des applications bénéficient d'un diagnostic de sécurité "acceptable" lors de leur première soumission et en prenant en compte leur criticité. Les applications web (y compris en "cloud"), qui sont heureusement les plus souvent testées, sont aussi les plus sensibles puisque 80% d'entre elles ne sont pas considérés comme suffisamment sécurisées pour passer un audit PCI (Payment Card Industry). Un autre axe d'analyse démontre par ailleurs que le "code tiers" (les composants externes, libres ou non, intégrés dans des solutions globales) est une source importante de failles de sécurité, avec 81% d'échec aux tests.

Et alors qu'on aurait pu espérer que les banques, compagnies d'assurance et autres institutions financières, plus sensibles à la sécurité, soient mieux placées, il n'en est rien : leurs résultats se situent au niveau de la moyenne générale.

La seule note positive du rapport de Veracode est que la correction des failles est de plus en plus rapide, ce qui montre que la maîtrise des exigences de sécurité progresse parmi les développeurs, aidés en cela par des outils plus perfectionnés. Mais la sensibilisation et la formation des professionnels, ainsi que la prise en compte de la sécurité tout au long des processus de développement (de la conception aux tests), méritent encore de gros efforts pour éviter des attaques qui peuvent devenir catastrophiques pour les entreprises.

Web et mobile social selon American Express

Après une première incursion dans les réseaux sociaux pour professionnels (l'American Express OPEN Forum), AmEx annonce une nouvelle initiative ambitieuse dans le web social, ciblant cette fois les jeunes adultes, sous la forme d'un nouveau service, Currency, et d'une application mobile, Social Currency.

Réalisé en partenariat avec l'agence spécialisée Federated Media, le site web Currency propose des conseils sur la gestion de finances personnelles, avec des articles et de véritables cours rédigés par une équipe de spécialistes, et offre un espace de dialogue ouvert entre ses membres, leur permettant de partager leurs propres idées avec leurs pairs.

Plus originale et plus audacieuse, l'application mobile Social Currency (pour iPhone uniquement, pour l'instant) invite ses utilisateurs à partager en temps réel leurs achats et leurs envies avec leurs amis. Pour ce faire, elle est combinée à la plate-forme de géolocalisation sociale de FourSquare : après le « check-in » (publication de sa position sur FourSquare), l'utilisateur peut indiquer l'achat qu'il vient de réaliser ou celui dont il rêve, en y associant éventuellement une photo.

Réalisé en partenariat avec l'agence spécialisée Federated Media, le site web Currency propose des conseils sur la gestion de finances personnelles, avec des articles et de véritables cours rédigés par une équipe de spécialistes, et offre un espace de dialogue ouvert entre ses membres, leur permettant de partager leurs propres idées avec leurs pairs.

Plus originale et plus audacieuse, l'application mobile Social Currency (pour iPhone uniquement, pour l'instant) invite ses utilisateurs à partager en temps réel leurs achats et leurs envies avec leurs amis. Pour ce faire, elle est combinée à la plate-forme de géolocalisation sociale de FourSquare : après le « check-in » (publication de sa position sur FourSquare), l'utilisateur peut indiquer l'achat qu'il vient de réaliser ou celui dont il rêve, en y associant éventuellement une photo.

Sans être aussi disruptive que Swipely, le réseau social mobile d'achats lancé tout récemment, l'application Social Currency démontre la capacité d'American Express à s'aventurer sur un terrain encore peu exploré, où les risques de polémique et de rejet ne sont pas à écarter (notamment par rapport à la sécurité et la gestion des données personnelles). Un exemple de la part d'une entreprise « traditionnelle » (par opposition aux « startups qui osent tout »), que l'on aimerait voir suivre par d'autres…

jeudi 23 septembre 2010

J'adore mon Kindle

Malgré quelques mésaventures de livraison (les services d'UPS sont toujours aussi déplorables en France), j'ai finir par recevoir fin août le Kindle qui m'a été offert par mes ex-collègues (encore merci à eux). Les presque deux mois d'attente m'ont permis de bénéficier de la toute nouvelle version du lecteur de livres électronique d'Amazon, ce qui a finalement compensé mon impatience et ma frustration...

Après quelques semaines d'utilisation, dont la lecture (passionnante) de "Empowered", je vous propose ici une petite revue des possibilités de cet appareil, qui m'a définitivement conquis. En préambule, je préciserai tout de même que mes habitudes de lecture influent sur mon avis, notamment sur deux aspects : je suis déjà lecteur de livres électroniques depuis une dizaine d'années (à l'époque sur mon Palm) et une forte proportion (plus de 50%) de mes lectures, électroniques ou non, est en anglais.

Prise en main

Dès l'ouverture du colis et malgré une lecture attentive de ses spécifications, le Kindle étonne par ses dimensions, à peine supérieures à celles d'un livre de poche mais beaucoup plus fin (8 mm), et son poids (232 g), équivalent à celui d'un livre de poche. La surface de l'écran est un peu petite, ce qui s'explique par la présence d'un clavier, indispensable (malheureusement) pour quelques opérations.

La "magie" du Kindle se révèle cependant à l'allumage, l'affichage étant réellement extraordinaire. Rappelons que la technologie utilisée est une "encre électronique", qui n'a rien de comparable aux écrans que nous connaissons sur les appareils électroniques classiques. Cet affichage monochrome (avec niveaux de gris) est idéal pour la lecture de livres et la qualité de lecture est réellement proche de celle d'un livre imprimé, par son apparence, sa finesse et son contraste.

Bibliothèque

Après enregistrement de son compte Amazon (une des opérations qui requièrent le clavier), le Kindle donne immédiatement accès à une boutique géante de livres électroniques, comprenant presque 500 000 titres en anglais (dont de nombreux gratuits), quoique certains ne soient pas disponibles en France. Immédiatement après l'achat, le livre choisi est téléchargé sur le lecteur, en quelques secondes, soit en WiFi soit, pour le modèle que j'ai, en 3G via un abonnement inclus avec l'appareil (et sans frais supplémentaires).

Une sélection de périodiques est également proposée en abonnement, mais elle est encore limitée (Le Monde est le seul journal français disponible à ce jour). Dans ce cas, chaque numéro est automatiquement chargé dès sa pulication sur le Kindle. Malheureusement, les illustrations sont exclues des versions électroniques en dehors des Etats-Unis.

La librairie d'Amazon n'est pas la seule source possible de lectures électroniques. Tout d'abord, le Kindle intègre un lecteur natif de documents au format PDF, dont la qualité de rendu est étonnante. Naturellement, l'affichage d'une page conçue pour un format A4 sur un petit écran donne un résultat illisible mais cette option peut tout de même être utile pour des documents PDF dont la mise en page est adaptée.

Le Kindle peut également lire des livres au format Mobipocket (sans DRM), assez répandu. Et, si on peut regretter que d'autres formats ne soient pas supportés nativement, l'utilisation d'un logiciel comme Calibre permet de convertir les formats les plus populaires, pour un résultat souvent proche de la perfection, notamment à partir de fichiers au standard ePub.

Pour tous les documents personnels, Amazon met à disposition de ses clients une adresse de messagerie dédiée qui permet de les transférer très simplement sur le Kindle (avec une option de conversion automatique de documents bureautiques). Cette adresse peut même être partagée avec ses amis, qui peuvent alors vous envoyer des livres directement (cette fonction est protégée, naturellement !). L'appareil peut aussi être connecté à un ordinateur personnel avec un câble USB fourni, et les transferts peuvent alors s'effectuer par une simple copie de fichiers.

A l'usage

En dehors de la qualité de lecture exceptionnelle, une des principales forces du Kindle est son autonomie. Grâce à la technologie d'affichage employée (qui consomme de l'électricité uniquement lors du changement de page), une charge peut offrir plusieurs semaines de fonctionnement, si on prend soin de désactiver les connexions sans fil lorsqu'elles ne sont pas utilisées.

En revanche, cette technologie est aussi le (petit) point faible de l'appareil : le passage d'une page à une autre se fait par une transition au noir, à laquelle il faut s'habituer. Je dois également signaler que si, en temps normal, la réactivité est tout à fait acceptable (moins de 2 secondes pour afficher une page), le logiciel du Kindle comporte quelques bugs qui peuvent parfois le rendre extrêmement lent. Dans ce cas, une réinitialisation complète (mais sans perte de données) est la seule solution que j'aie pu trouver.

Et aussi...

En complément de la simple lecture de livres, le Kindle dispose de quelques fonctions "accessoires" :

Conclusions

Le Kindle mérite largement le succès qu'il rencontre aux Etats-Unis et je pense l'utiliser pour la majorité de mes lectures (en attendant une bibliothèque francophone). Pour un usage professionnel, j'envisage déjà quelques cas où il me rendra service, pour un accès rapide à certains documents.

Mais de là à imaginer une possible généralisation de ce type de lecteurs en entreprise, il reste du chemin à parcourir. Il faudra tout d'abord populariser l'adoption des documents au format électronique (et pas uniquement pour les imprimer). Les champions du Green IT ont encore du travail devant eux !

Après quelques semaines d'utilisation, dont la lecture (passionnante) de "Empowered", je vous propose ici une petite revue des possibilités de cet appareil, qui m'a définitivement conquis. En préambule, je préciserai tout de même que mes habitudes de lecture influent sur mon avis, notamment sur deux aspects : je suis déjà lecteur de livres électroniques depuis une dizaine d'années (à l'époque sur mon Palm) et une forte proportion (plus de 50%) de mes lectures, électroniques ou non, est en anglais.

Prise en main

Dès l'ouverture du colis et malgré une lecture attentive de ses spécifications, le Kindle étonne par ses dimensions, à peine supérieures à celles d'un livre de poche mais beaucoup plus fin (8 mm), et son poids (232 g), équivalent à celui d'un livre de poche. La surface de l'écran est un peu petite, ce qui s'explique par la présence d'un clavier, indispensable (malheureusement) pour quelques opérations.

La "magie" du Kindle se révèle cependant à l'allumage, l'affichage étant réellement extraordinaire. Rappelons que la technologie utilisée est une "encre électronique", qui n'a rien de comparable aux écrans que nous connaissons sur les appareils électroniques classiques. Cet affichage monochrome (avec niveaux de gris) est idéal pour la lecture de livres et la qualité de lecture est réellement proche de celle d'un livre imprimé, par son apparence, sa finesse et son contraste.

Bibliothèque

Après enregistrement de son compte Amazon (une des opérations qui requièrent le clavier), le Kindle donne immédiatement accès à une boutique géante de livres électroniques, comprenant presque 500 000 titres en anglais (dont de nombreux gratuits), quoique certains ne soient pas disponibles en France. Immédiatement après l'achat, le livre choisi est téléchargé sur le lecteur, en quelques secondes, soit en WiFi soit, pour le modèle que j'ai, en 3G via un abonnement inclus avec l'appareil (et sans frais supplémentaires).

Une sélection de périodiques est également proposée en abonnement, mais elle est encore limitée (Le Monde est le seul journal français disponible à ce jour). Dans ce cas, chaque numéro est automatiquement chargé dès sa pulication sur le Kindle. Malheureusement, les illustrations sont exclues des versions électroniques en dehors des Etats-Unis.

La librairie d'Amazon n'est pas la seule source possible de lectures électroniques. Tout d'abord, le Kindle intègre un lecteur natif de documents au format PDF, dont la qualité de rendu est étonnante. Naturellement, l'affichage d'une page conçue pour un format A4 sur un petit écran donne un résultat illisible mais cette option peut tout de même être utile pour des documents PDF dont la mise en page est adaptée.

Le Kindle peut également lire des livres au format Mobipocket (sans DRM), assez répandu. Et, si on peut regretter que d'autres formats ne soient pas supportés nativement, l'utilisation d'un logiciel comme Calibre permet de convertir les formats les plus populaires, pour un résultat souvent proche de la perfection, notamment à partir de fichiers au standard ePub.

Pour tous les documents personnels, Amazon met à disposition de ses clients une adresse de messagerie dédiée qui permet de les transférer très simplement sur le Kindle (avec une option de conversion automatique de documents bureautiques). Cette adresse peut même être partagée avec ses amis, qui peuvent alors vous envoyer des livres directement (cette fonction est protégée, naturellement !). L'appareil peut aussi être connecté à un ordinateur personnel avec un câble USB fourni, et les transferts peuvent alors s'effectuer par une simple copie de fichiers.

A l'usage

En dehors de la qualité de lecture exceptionnelle, une des principales forces du Kindle est son autonomie. Grâce à la technologie d'affichage employée (qui consomme de l'électricité uniquement lors du changement de page), une charge peut offrir plusieurs semaines de fonctionnement, si on prend soin de désactiver les connexions sans fil lorsqu'elles ne sont pas utilisées.

En revanche, cette technologie est aussi le (petit) point faible de l'appareil : le passage d'une page à une autre se fait par une transition au noir, à laquelle il faut s'habituer. Je dois également signaler que si, en temps normal, la réactivité est tout à fait acceptable (moins de 2 secondes pour afficher une page), le logiciel du Kindle comporte quelques bugs qui peuvent parfois le rendre extrêmement lent. Dans ce cas, une réinitialisation complète (mais sans perte de données) est la seule solution que j'aie pu trouver.

Et aussi...

En complément de la simple lecture de livres, le Kindle dispose de quelques fonctions "accessoires" :

- La possibilité de "marquer" des passages dans les livres lus et d'y ajouter des annotations.

- Le partage "social" des passages surlignés, qui permet de signaler (en option) dans chaque livre les extraits les plus populaires parmi la communauté des utilisateurs.

- La présence de deux dictionnaires (anglais et américain), accessibles directement depuis les livres (les définitions d'un mot sélectionné apparaissent automatiquement en bas de page).

- Un navigateur web, pour une utilisation occasionnelle (malgré sa qualité, l'affichage du Kindle n'est pas adapté à cet usage et, de plus, l'accès web n'est possible qu'en WiFi).

Conclusions

Le Kindle mérite largement le succès qu'il rencontre aux Etats-Unis et je pense l'utiliser pour la majorité de mes lectures (en attendant une bibliothèque francophone). Pour un usage professionnel, j'envisage déjà quelques cas où il me rendra service, pour un accès rapide à certains documents.

Mais de là à imaginer une possible généralisation de ce type de lecteurs en entreprise, il reste du chemin à parcourir. Il faudra tout d'abord populariser l'adoption des documents au format électronique (et pas uniquement pour les imprimer). Les champions du Green IT ont encore du travail devant eux !

mercredi 22 septembre 2010

PayNearMe : payer en espèces les achats en ligne

Après une courte période de test, PayNearMe (ex-Kwedit) annonce le lancement officiel de sa solution de paiement en espèces pour les achats en ligne, avec un partenaire de poids, 7-Eleven, qui lui apporte une crédibilité certaine.

Pour le consommateur, PayNearMe apparaîtra comme un nouveau moyen de paiement proposé lors de ses achats en ligne. Après sélection de cette option, l'acheteur imprime un coupon qu'il doit présenter dans un des 6 000 7-Eleven présents sur le territoire américain, où il règle le montant dû. Les terminaux du commerçant de proximité, directement reliés au réseau de paiement de PayNearMe, permettent de valider immédiatement la transaction auprès du commerçant, qui peut alors procéder à la "livraison". Cerise sur le gâteau, le reçu imprimé lors du paiement peut inclure un message personnalisé par le marchand, par exemple une promotion ou un code de réduction.

Pour son lancement, PayNearMe a aussi enrôlé deux partenaires commerçants importants : Facebook, pour l'achat des "crédits" du réseau social ("Facebook credits") et Amazon, pour l'achat de bons cadeaux ("gift cards"). Un autre utilisateur du service est Progreso Financiero, établissement financier pour les familles hispaniques sous-bancarisées, qui propose le système à ses clients pour le remboursement de leurs emprunts.

Avec sa solution, la startup cible les 25% de foyers américains qui ne possèdent pas de carte de paiement, pour lesquels le commerce en ligne est quasiment inaccessible aujourd'hui. Et elle promet un coût inférieur aux moyens de paiement alternatifs (cartes prépayées, virements...), grâce à sa plate-forme technologique automatisant la gestion des flux de paiement, et par l'élimination de tout risque de fraude. De plus, l'intégration pour les commerçants est transparente, sous réserve que leur site permette le "staging" des commandes (gestion d'un état "en attente de paiement").

En signant un partenariat avec 7-Eleven et son immense réseau de points de vente, PayNearMe devient effectivement un acteur crédible dans le monde du paiement, qui permettra aux "e-commerçants" d'atteindre des populations qui leur échappaient jusqu'à maintenant : les millions d'américains sous-bancarisés, mais également tous ceux qui sont réticents à l'achat en ligne pour des raisons de sécurité.

Pour le consommateur, PayNearMe apparaîtra comme un nouveau moyen de paiement proposé lors de ses achats en ligne. Après sélection de cette option, l'acheteur imprime un coupon qu'il doit présenter dans un des 6 000 7-Eleven présents sur le territoire américain, où il règle le montant dû. Les terminaux du commerçant de proximité, directement reliés au réseau de paiement de PayNearMe, permettent de valider immédiatement la transaction auprès du commerçant, qui peut alors procéder à la "livraison". Cerise sur le gâteau, le reçu imprimé lors du paiement peut inclure un message personnalisé par le marchand, par exemple une promotion ou un code de réduction.

Pour son lancement, PayNearMe a aussi enrôlé deux partenaires commerçants importants : Facebook, pour l'achat des "crédits" du réseau social ("Facebook credits") et Amazon, pour l'achat de bons cadeaux ("gift cards"). Un autre utilisateur du service est Progreso Financiero, établissement financier pour les familles hispaniques sous-bancarisées, qui propose le système à ses clients pour le remboursement de leurs emprunts.

Avec sa solution, la startup cible les 25% de foyers américains qui ne possèdent pas de carte de paiement, pour lesquels le commerce en ligne est quasiment inaccessible aujourd'hui. Et elle promet un coût inférieur aux moyens de paiement alternatifs (cartes prépayées, virements...), grâce à sa plate-forme technologique automatisant la gestion des flux de paiement, et par l'élimination de tout risque de fraude. De plus, l'intégration pour les commerçants est transparente, sous réserve que leur site permette le "staging" des commandes (gestion d'un état "en attente de paiement").

En signant un partenariat avec 7-Eleven et son immense réseau de points de vente, PayNearMe devient effectivement un acteur crédible dans le monde du paiement, qui permettra aux "e-commerçants" d'atteindre des populations qui leur échappaient jusqu'à maintenant : les millions d'américains sous-bancarisés, mais également tous ceux qui sont réticents à l'achat en ligne pour des raisons de sécurité.

mardi 21 septembre 2010

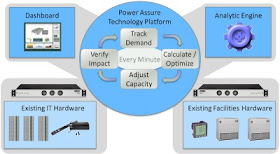

Power Assure ajuste dynamiquement la consommation électrique du data center

Power Assure, spécialiste de l'optimisation des centres de production informatique (data centers), annonce la disponibilité de sa nouvelle offre logicielle Dynamic Power Optimization, promettant une réduction de moitié de la consommation électrique.

Pour atteindre cet objectif, la solution combine un moteur d'analyse en temps réel de la charge supportée par les infrastructures et un système de contrôle sur les installations matérielles (serveurs, alimentations, refroidissement...). Ainsi, à partir des mesures de charges et un suivi précis des besoins de ressources informatiques, corrélés aux exigences de qualité de service, le logiciel ajuste dynamiquement la capacité informatique disponible à chaque instant.

La consommation énergétique des data centers est au centre des préoccupations de beaucoup d'entreprises, en partie dans une logique de développement durable mais aussi, et surtout, pour des raisons économiques, qui ne feront que s'aggraver avec l'augmentation inexorable du prix de l'électricité.

Les solutions disponibles sont extrêmement variées mais les responsables des centres de production préfèrent naturellement celles qui n'ont pas d'impact sur le fonctionnement des systèmes. L'adoption de composants plus efficaces (serveurs, équipement électriques et de refroidissement, principalement) et un aménagement optimisé du centre constituent ainsi les voies les plus faciles. Plus radicales, les nouvelles techniques de refroidissement (et, à l'extrême, le "free cooling") font face à plus de réticence et sont donc beaucoup moins répandues. Même la virtualisation, qui permet de mieux utiliser la puissance informatique disponible est encore loin de la généralisation (les taux de virtualisation de 20% sont encore courants dans les grandes structures), alors qu'elle est désormais bien maîtrisée.

Par conséquent, les techniques qui veulent interagir directement avec les équipements, comme celle de Power Assure (et comme celles qui proposent d'éteindre les serveurs lorsqu'ils ne sont pas utilisés), vont devoir affronter une forte résistance dans les data centers. Pour réussir, il leur faudra démontrer leur efficacité mais également prouver dans le même temps une fiabilité absolue, dans des contextes de production. Le tout sans complexité d'installation et de gestion (ce que promet Power Assure).

La route sera probablement longue mais il ne fait aucun doute que ces approches ont un avenir : après avoir optimisé l'efficacité électrique des équipements puis le taux d'utilisation des serveurs (avec la virtualisation), l'étape suivante est inévitablement d'ajuster la puissance informatique à la demande à laquelle les applications doivent faire face, en temps réel. La NASA, qui a sélectionné les solutions de Power Assure, nous montrera peut-être la voie...

Pour atteindre cet objectif, la solution combine un moteur d'analyse en temps réel de la charge supportée par les infrastructures et un système de contrôle sur les installations matérielles (serveurs, alimentations, refroidissement...). Ainsi, à partir des mesures de charges et un suivi précis des besoins de ressources informatiques, corrélés aux exigences de qualité de service, le logiciel ajuste dynamiquement la capacité informatique disponible à chaque instant.

La consommation énergétique des data centers est au centre des préoccupations de beaucoup d'entreprises, en partie dans une logique de développement durable mais aussi, et surtout, pour des raisons économiques, qui ne feront que s'aggraver avec l'augmentation inexorable du prix de l'électricité.

Les solutions disponibles sont extrêmement variées mais les responsables des centres de production préfèrent naturellement celles qui n'ont pas d'impact sur le fonctionnement des systèmes. L'adoption de composants plus efficaces (serveurs, équipement électriques et de refroidissement, principalement) et un aménagement optimisé du centre constituent ainsi les voies les plus faciles. Plus radicales, les nouvelles techniques de refroidissement (et, à l'extrême, le "free cooling") font face à plus de réticence et sont donc beaucoup moins répandues. Même la virtualisation, qui permet de mieux utiliser la puissance informatique disponible est encore loin de la généralisation (les taux de virtualisation de 20% sont encore courants dans les grandes structures), alors qu'elle est désormais bien maîtrisée.

Par conséquent, les techniques qui veulent interagir directement avec les équipements, comme celle de Power Assure (et comme celles qui proposent d'éteindre les serveurs lorsqu'ils ne sont pas utilisés), vont devoir affronter une forte résistance dans les data centers. Pour réussir, il leur faudra démontrer leur efficacité mais également prouver dans le même temps une fiabilité absolue, dans des contextes de production. Le tout sans complexité d'installation et de gestion (ce que promet Power Assure).

La route sera probablement longue mais il ne fait aucun doute que ces approches ont un avenir : après avoir optimisé l'efficacité électrique des équipements puis le taux d'utilisation des serveurs (avec la virtualisation), l'étape suivante est inévitablement d'ajuster la puissance informatique à la demande à laquelle les applications doivent faire face, en temps réel. La NASA, qui a sélectionné les solutions de Power Assure, nous montrera peut-être la voie...

lundi 20 septembre 2010

Coup de gueule : le cloud fumeux d'Oracle

A l'occasion de la keynote d'ouverture de l'OpenWorld 2010, Larry Elison a annoncé un "cloud en boîte" sous la forme d'une nouvelle offre nommée Exalogic Elastic Cloud. Le problème ? Ce produit n'est rien d'autre qu'une boîte noire comprenant serveur et logiciels de middleware (en quelque sorte l'infrastructure logicielle) et tout cela n'a aucun rapport avec le cloud computing.

Lorsqu'un mastodonte du logiciel se lance ainsi dans une opération de "cloudwashing" (encore une expression personnelle, pour décrire l'utilisation du terme "cloud" uniquement à des fins marketing), il y a de quoi s'inquiéter. Alors que le cloud computing a déjà du mal à pénétrer dans les entreprises, ce type d'annonce fracassante va encore ajouter à la confusion qui règne et renforcer la méfiance vis-à-vis des "vraies" offres. Au pire, nous verrons peut-être quelques DSI se laisser convaincre par Oracle, pour s'apercevoir plus tard qu'ils n'ont obtenu aucun des bénéfices promis par le cloud, ratant ainsi des opportunités réelles.

Le seul aspect positif de cette annonce est de prouver la réalité du cloud, qu'Oracle doit considérer comme suffisant menaçant pour ses activités (ce qui est incontestable) pour justifier une telle tentative de détournement...

Lorsqu'un mastodonte du logiciel se lance ainsi dans une opération de "cloudwashing" (encore une expression personnelle, pour décrire l'utilisation du terme "cloud" uniquement à des fins marketing), il y a de quoi s'inquiéter. Alors que le cloud computing a déjà du mal à pénétrer dans les entreprises, ce type d'annonce fracassante va encore ajouter à la confusion qui règne et renforcer la méfiance vis-à-vis des "vraies" offres. Au pire, nous verrons peut-être quelques DSI se laisser convaincre par Oracle, pour s'apercevoir plus tard qu'ils n'ont obtenu aucun des bénéfices promis par le cloud, ratant ainsi des opportunités réelles.

Le seul aspect positif de cette annonce est de prouver la réalité du cloud, qu'Oracle doit considérer comme suffisant menaçant pour ses activités (ce qui est incontestable) pour justifier une telle tentative de détournement...

Les Google Apps mieux sécurisées

Soucieux de la sécurité de ses applications dans le "cloud", Google annonce la mise en place d'une authentification à deux facteurs, par mobile, sur les Google Apps. Ce nouveau système gratuit est disponible dès maintenant pour les clients des versions "entreprise" et devrait être généralisé à tous les utilisateurs d'ici quelques mois.

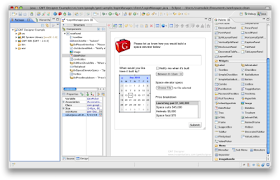

L'authentification web à deux facteurs consiste à compléter la sécurité classique par couple identifiant - mot de passe (le premier facteur, qui peut être compromis) d'un deuxième facteur généralement géré par un dispositif indépendant. Dans le cas de Google, ce dispositif est le mobile de l'utilisateur, qui recevra un deuxième code secret, à usage unique, via SMS ou serveur vocal ou encore grâce à une application pour Android, Blackberry et iPhone. Il ne reste qu'à saisir ce code pour finaliser l'accès au site :

L'ajout d'un mécanisme de sécurité renforcé est une nouvelle étape pour Google dans sa stratégie de conquête des entreprises. En effet, la sécurité reste le facteur numéro 1 des craintes des DSI vis-à-vis des offres dans le "cloud" et tout effort dans ce domaine concourt à réduire les réticences. Il ne faudrait pas croire pour autant que le système d'authentification proposé éliminera tous les risques : il reste en effet sensible aux attaques de type "man in the middle" (qui, pour simplifier, sont celles dans lesquelles un pirate prend le contrôle du navigateur ou du PC de l'utilisateur).

Le plus intéressant dans cette annonce est cependant la démonstration de faisabilité que nous offre Google : alors que la plupart des sites de banque en ligne en sont encore à la protection par mot de passe et que nos banquiers ne veulent pas investir dans une meilleure sécurisation, Google leur prouve qu'un déploiement massif est possible et économiquement viable !

L'authentification web à deux facteurs consiste à compléter la sécurité classique par couple identifiant - mot de passe (le premier facteur, qui peut être compromis) d'un deuxième facteur généralement géré par un dispositif indépendant. Dans le cas de Google, ce dispositif est le mobile de l'utilisateur, qui recevra un deuxième code secret, à usage unique, via SMS ou serveur vocal ou encore grâce à une application pour Android, Blackberry et iPhone. Il ne reste qu'à saisir ce code pour finaliser l'accès au site :

L'ajout d'un mécanisme de sécurité renforcé est une nouvelle étape pour Google dans sa stratégie de conquête des entreprises. En effet, la sécurité reste le facteur numéro 1 des craintes des DSI vis-à-vis des offres dans le "cloud" et tout effort dans ce domaine concourt à réduire les réticences. Il ne faudrait pas croire pour autant que le système d'authentification proposé éliminera tous les risques : il reste en effet sensible aux attaques de type "man in the middle" (qui, pour simplifier, sont celles dans lesquelles un pirate prend le contrôle du navigateur ou du PC de l'utilisateur).

Le plus intéressant dans cette annonce est cependant la démonstration de faisabilité que nous offre Google : alors que la plupart des sites de banque en ligne en sont encore à la protection par mot de passe et que nos banquiers ne veulent pas investir dans une meilleure sécurisation, Google leur prouve qu'un déploiement massif est possible et économiquement viable !

L'application Mes Comptes de BNP Paribas arrive sur Android

Après la version iPhone de son application de banque mobile, BNP Paribas annonce la disponibilité de "Mes Comptes" sur l'Android Market. La banque rejoint ainsi le CIC et le Crédit Mutuel, qui sont également présentes depuis peu sur Android (avec la même application, adaptée aux couleurs de chaque établissement).

Alors que le système mobile de Google est en très forte croissance aux Etats-Unis, le phénomène est moins marqué en France, du fait, notamment, de la disponibilité de l'iPhone (qui reste la référence des smartphones) chez les 3 opérateurs principaux. Mais, bien que le téléphone d'Apple jouisse d'une position particulière, la vague Android va certainement arriver dans l'hexagone et il est logique que les banques l'anticipent.

"Mes Comptes" pour Android est identique à la version iPhone, proposant aux clients de la banque l'accès aux comptes, la recherche d'agence et quelques simulateurs. Quelle déception ! BNP Paribas semble en effet rester sourde aux commentaires de ses clients sur l'AppStore, qui se plaignent assez largement de la pauvreté de l'application dont l'accès au compte n'est qu'un réhabillage du site de banque en ligne mobile. Il aurait peut-être été plus sage pour la banque de répondre aux attentes de ses utilisateurs avant de se lancer sur Android...

Et les chiffres "officiels" confirment la déception : BNP Paribas se félicitait au début du mois d'avoir atteint 100 000 téléchargements de "Mes Comptes" pour iPhone, ce qui constitue, à mon avis, un niveau honorable mais pas extraordinaire (à mettre en regard des plus de 3 millions d'iPhones vendus en France). Selon mes estimations, "L'Appli" de la Société Générale a probablement atteint le double de ce nombre sur la même période. Les clients de BNP Paribas n'hésitent d'ailleurs pas dans leurs commentaires à faire la comparaison avec sa concurrente (qui a eu la belle idée de rendre partiellement utilisable son application par des non clients) et cela devrait être une source d'inspiration. Dans le monde hyperconnecté d'aujourd'hui, la stratégie gagnante de l'entreprise est de rester à l'écoute de ses clients et d'être réactive par rapport à leurs attentes...

Alors que le système mobile de Google est en très forte croissance aux Etats-Unis, le phénomène est moins marqué en France, du fait, notamment, de la disponibilité de l'iPhone (qui reste la référence des smartphones) chez les 3 opérateurs principaux. Mais, bien que le téléphone d'Apple jouisse d'une position particulière, la vague Android va certainement arriver dans l'hexagone et il est logique que les banques l'anticipent.

"Mes Comptes" pour Android est identique à la version iPhone, proposant aux clients de la banque l'accès aux comptes, la recherche d'agence et quelques simulateurs. Quelle déception ! BNP Paribas semble en effet rester sourde aux commentaires de ses clients sur l'AppStore, qui se plaignent assez largement de la pauvreté de l'application dont l'accès au compte n'est qu'un réhabillage du site de banque en ligne mobile. Il aurait peut-être été plus sage pour la banque de répondre aux attentes de ses utilisateurs avant de se lancer sur Android...

Et les chiffres "officiels" confirment la déception : BNP Paribas se félicitait au début du mois d'avoir atteint 100 000 téléchargements de "Mes Comptes" pour iPhone, ce qui constitue, à mon avis, un niveau honorable mais pas extraordinaire (à mettre en regard des plus de 3 millions d'iPhones vendus en France). Selon mes estimations, "L'Appli" de la Société Générale a probablement atteint le double de ce nombre sur la même période. Les clients de BNP Paribas n'hésitent d'ailleurs pas dans leurs commentaires à faire la comparaison avec sa concurrente (qui a eu la belle idée de rendre partiellement utilisable son application par des non clients) et cela devrait être une source d'inspiration. Dans le monde hyperconnecté d'aujourd'hui, la stratégie gagnante de l'entreprise est de rester à l'écoute de ses clients et d'être réactive par rapport à leurs attentes...

dimanche 19 septembre 2010

Quelques idées pour la banque mobile (Celent)

Red Gillen, analyste chez Celent, évoque sur son blog quelques idées d'applications mobiles (au sens large) qui devraient émerger dans les mois qui viennent dans la banque de détail, issues de ses échanges avec les institutions financières et les fournisseurs.

Il passe d'abord rapidement en revue 3 thèmes approchant de la maturité : paiements P2P (qui n'intéressent pas beaucoup les banques), dépôt de chèque sur mobile (en croissance aux Etats-Unis mais nulle part ailleurs) et paiement sur mobile sans contact (soulevant beaucoup d'espoir, sans que l'on sache toujours pourquoi, et dont le décollage tarde toujours).

Il poursuit avec quelques idées un peu plus intéressantes, parmi lesquelles :

Il passe d'abord rapidement en revue 3 thèmes approchant de la maturité : paiements P2P (qui n'intéressent pas beaucoup les banques), dépôt de chèque sur mobile (en croissance aux Etats-Unis mais nulle part ailleurs) et paiement sur mobile sans contact (soulevant beaucoup d'espoir, sans que l'on sache toujours pourquoi, et dont le décollage tarde toujours).

Il poursuit avec quelques idées un peu plus intéressantes, parmi lesquelles :

- La réalité augmentée, non plus seulement pour localiser les agences et automates mais pour fournir des informations riches aux clients (horaires d'ouverture, services disponibles, promotions...).

Une fois la curiosité des consommateurs pour les applications de réalité augmentée passée, il va bien falloir en trouver un usage à valeur ajoutée. L'intégration d'informations pratiques (très visibles, par rapport à ce qui existe aujourd'hui) peut être une piste dans ce sens mais il me semble qu'elle n'aura pas d'avenir si son périmètre est restreint à la banque. Le client sera en effet certainement plus attiré par une application qui lui permet d'obtenir ces informations pour tous les commerces et services qui l'entourent...

- La personnalisation par l'utilisateur des portails mobiles des banques, sur les modèles des portails dynamiques de type iGoogle.

Cette idée pourra certainement répondre aux attentes de nombreux clients qui veulent accéder rapidement aux informations qui les intéressent. Elle est d'ailleurs également applicable aux applications pour smartphones. Cependant, quand on voit la rareté des possibilités de personnalisation sur les sites de banque en ligne, leur arrivée sur mobile, où elles sont encore plus cruciales, risque d'être lointaine...

- La numérisation des reçus d'achats, qui permettrait de faciliter l'utilisation des outils de PFM (gestion de finances personnelles) en évitant la resaisie des informations.

Il s'agit encore, à mon avis, d'une fonction "gadget" dont le côté ludique pourra séduire les clients des premiers établissements qui la proposeront. Mais la promesse du PFM étant aussi d'automatiser l'acquisition d'information sur les dépenses et leur catégorisation, une étape manuelle dans le processus est plutôt une régression. Reste le cas des achats en espèces, bien que je doute que beaucoup d'utilisateurs de PFM les incluent dans leurs analyses. De plus, si le paiement sans contact sur mobile finit par s'imposer (y compris pour les achats de petits montants), la gestion des reçus pourra être entièrement dématérialisée, rendant cette application obsolète.

- Les conseillers en agence équipés de tablettes (iPad) pour répondre plus rapidement aux attentes des clients qui font la queue devant les guichets.

Il s'agit d'une des applications les plus évidentes de ces appareils. La difficulté pour les banques sera de justifier l'investissement nécessaire, non seulement en matériel mais également en logiciels, infrastructures et services.

samedi 18 septembre 2010

Blackberry en entreprise, une domination menacée

Malgré quelques rares exceptions, le Blackberry est le mobile préféré des entreprises pour leurs collaborateurs, grâce, notamment, au niveau de sécurité (réel ou perçu) qu'il apporte dans les communications avec les serveurs internes. Trois ans après le lancement de l'iPhone, cette domination commence seulement à être sérieusement menacée.

Un article de Bloomberg News nous apprend ainsi que JPMorgan serait en train d'évaluer l'iPhone et Android en substitution au classique Blackberry distribué à ses collaborateurs. Et ce n'est pas la seule institution financière concernée : UBS et Vanguard Group ont également des tests en cours et Standard Chartered a annoncé son intention de distribuer 15 000 iPhones à ses employés d'ici la fin de l'année.

Pour toutes ces entreprises, la démarche initiale est identique : un premier test est réalisé avec quelques centaines d'appareils et la sécurité des nouveaux smartphones est soigneusement analysée. C'est d'ailleurs dans ce domaine que les progrès constants d'Apple lui permettent d'être désormais considéré comme un candidat sérieux à une utilisation en entreprise, après le rejet sans appel des premières versions.