Capitalisant sur les principes de l'innovation ouverte, OpenInvo vient de lancer (en version beta) sa place de marché destinée à rapprocher des fournisseurs d'idées et des sociétés ou personnes à la recherche de concepts novateurs à implémenter.

Les premiers sont invités à s'inscrire (gratuitement) et soumettre leurs propositions en détail, qui sont alors évaluées et valorisées par l'équipe d'OpenInvo. Les seconds souscrivent un abonnement (plusieurs formules sont disponibles) pour accéder aux idées qui correspondent aux attentes qu'ils expriment, le cas échéant.

Aux "inventeurs" la plate-forme offre ainsi une solution pour commercialiser les idées qu'ils ne souhaitent pas concrétiser eux-mêmes, ce qui distingue OpenInvo des sites existants sur ce créneau. Il leur est également possible d'entrer dans une démarche collaborative d'échange et de partage avec leurs pairs, pour, par exemple, affiner et développer des innovations qui ne sont pas suffisamment mûres.

Les "acheteurs" ont, de leur côté, accès à une source d'innovation ouverte permanente, qui, certes, leur laisse moins de contrôle que dans des initiatives ciblées mais, en contrepartie, réduit les difficultés, en particulier de "recrutement".

Reste que le succès dépendra de l'adhésion des deux parties et, quand il s'agit de commercialiser des idées, il peut être difficile de gagner la confiance des utilisateurs. Il est probable que la plate-forme évoluera encore beaucoup avant d'atteindre un modèle stable dans lequel tous les intervenants sont convaincus de la valeur qu'elle peut apporter. Pour ma part, je suis convaincu que cet objectif peut être atteint !

Annonce repérée via TechCrunch

vendredi 31 décembre 2010

Projet eGo : l'authentification au bout des doigts

Récompensé par un trophée Sésames de l'innovation dans la catégorie sécurité informatique, au salon Cartes 2010, le projet eGo de Gemalto et ses partenaires (dont Atos Worldline, l'INRIA, Precise Biometrics...) proposent une nouvelle approche de l'échange d'informations entre un utilisateur et des objets intelligents, aux nombreuses applications possibles.

Avec eGo, l'utilisateur porte sur lui, dans une montre, un vêtement, un bijou, une ceinture..., un dispositif intégrant ses informations d'identification et un capteur biométrique avec lequel il s'authentifie (par exemple un lecteur d'empreinte digitale). Dès lors, pour réaliser une "transaction", il suffit de poser un doigt sur le "lecteur" eGo pour que les identifiants soient transmis, à travers la peau.

Parmi les multiples cas d'utilisation imaginés, j'en soulignerai deux. Le premier est celui du contrôle d'accès à un micro-ordinateur : la souris ou le clavier intègre le "lecteur" eGo et le simple fait de le toucher suffit à communiquer au PC l'identification et les droits d'accès de l'utilisateur. Le second concerne le domaine des paiements : l'acheteur "touche" le terminal du commerçant pour choisir son mode de paiement et transmettre les informations nécessaires à la transaction. Les autres idées d'applications se partagent entre les problématiques d'identification et la personnalisation des interactions entre une personne et un appareil.

Le concept développé par Gemalto et ses partenaires rappelle beaucoup celui proposé par la startup française Natural Security qui était aussi finaliste des trophées Sésames de l'Innovation dans la catégorie Banque / Commerce / Fidélité. Dans ce cas le dispositif est composé d'une carte avec capteur biométrique et d'un lecteur qui communique avec la carte par ondes radio à courte portée, la transaction restant délenchée par un geste volontaire de l'utilisateur (toucher du doigt) pour éviter les possibles détournements.

Ces innovations mettent en évidence une transition dans le domaine de la sécurité biométrique. On passe ainsi progressivement de systèmes centralisés, où les capteurs et les données d'identification sont "attachés" aux "applications", à un mode dans lequel c'est l'utilisateur qui possède et contrôle les éléments essentiels de la chaîne d'identification. Cette évolution devrait faciliter l'adoption de ces technologies, en satisfaisant directement les exigences de la CNIL et des organismes équivalents dans d'autres pays, qui voient d'un mauvais oeil la constitution de bases de données de données personnelles sensibles (telles que les données biométriques).

Avec eGo, l'utilisateur porte sur lui, dans une montre, un vêtement, un bijou, une ceinture..., un dispositif intégrant ses informations d'identification et un capteur biométrique avec lequel il s'authentifie (par exemple un lecteur d'empreinte digitale). Dès lors, pour réaliser une "transaction", il suffit de poser un doigt sur le "lecteur" eGo pour que les identifiants soient transmis, à travers la peau.

Parmi les multiples cas d'utilisation imaginés, j'en soulignerai deux. Le premier est celui du contrôle d'accès à un micro-ordinateur : la souris ou le clavier intègre le "lecteur" eGo et le simple fait de le toucher suffit à communiquer au PC l'identification et les droits d'accès de l'utilisateur. Le second concerne le domaine des paiements : l'acheteur "touche" le terminal du commerçant pour choisir son mode de paiement et transmettre les informations nécessaires à la transaction. Les autres idées d'applications se partagent entre les problématiques d'identification et la personnalisation des interactions entre une personne et un appareil.

Le concept développé par Gemalto et ses partenaires rappelle beaucoup celui proposé par la startup française Natural Security qui était aussi finaliste des trophées Sésames de l'Innovation dans la catégorie Banque / Commerce / Fidélité. Dans ce cas le dispositif est composé d'une carte avec capteur biométrique et d'un lecteur qui communique avec la carte par ondes radio à courte portée, la transaction restant délenchée par un geste volontaire de l'utilisateur (toucher du doigt) pour éviter les possibles détournements.

Ces innovations mettent en évidence une transition dans le domaine de la sécurité biométrique. On passe ainsi progressivement de systèmes centralisés, où les capteurs et les données d'identification sont "attachés" aux "applications", à un mode dans lequel c'est l'utilisateur qui possède et contrôle les éléments essentiels de la chaîne d'identification. Cette évolution devrait faciliter l'adoption de ces technologies, en satisfaisant directement les exigences de la CNIL et des organismes équivalents dans d'autres pays, qui voient d'un mauvais oeil la constitution de bases de données de données personnelles sensibles (telles que les données biométriques).

mercredi 29 décembre 2010

Santander déploie des cartes multi-applications dans les universités

L'initiative n'est pas récente puisqu'elle a été lancée en 1995, mais une étude de cas [lien PDF] publiée par Gemalto nous donne l'occasion de nous pencher un instant sur l'offre du groupe Santander de distribution de cartes intelligentes (smart cards) dans les universités, adoptée par plus de 200 d'entre elles dans 10 pays à travers le monde.

Les cartes sont distribuées gratuitement aux étudiants et personnels des universités partenaires, dans le cadre de l'action "Santander Universidades" de la banque pour la promotion de l'enseignement supérieur (au sein de son programme de responsabilité sociale et environnementale). Ce sont plus de 4 millions de cartes qui ont ainsi été déployées jusqu'à maintenant.

Au-delà de sa position de fabricant, Gemalto est aussi un véritable partenaire de l'opération, développant les services demandés par les utilisateurs. Et ceux-ci sont nombreux : cette carte d'étudiant intelligente sert non seulement pour l'identification mais peut aussi se transformer, selon les universités, en porte-monnaie électronique (pour les achats sur des distributeurs, pour les transports, les cantines...), en dispositif de contrôle d'accès (aux locaux, aux parkings, aux ordinateurs et kiosques en libre service...), en clé de signature électronique (pour la transmission sécurisée de mails et documents dématérialisés, pour des votes électroniques...), en carte de "pointage" et de contrôle des horaires...

Naturellement, la banque propose aussi, en option, d'ajouter à cette liste la fonction de carte bancaire, au standard EMV. En effet, il existe bien un objectif commercial derrière cette démarche : celui de se positionner au plus près du marché attractif des étudiants et d'imposer sa présence dans les universités partenaires.

Les cartes de Gemalto sont relativement classiques, disposant d'une puce sécurisée et d'une interface MiFare (un des standards de communication sans contact de la sphère NFC) et programmables via une interface Java. Pour l'avenir, Santander et Gemalto réfléchissent à l'intégration des mêmes fonctions dans les téléphones portables, quelques expérimentations ayant déjà été lancées.

La carte bancaire ISIC (carte internationale d'étudiant) lancée à grand renfort de communication par LCL l'an dernier (je crois) fait un peu pâle figure en comparaison de cette initiative de Santander...

Les cartes sont distribuées gratuitement aux étudiants et personnels des universités partenaires, dans le cadre de l'action "Santander Universidades" de la banque pour la promotion de l'enseignement supérieur (au sein de son programme de responsabilité sociale et environnementale). Ce sont plus de 4 millions de cartes qui ont ainsi été déployées jusqu'à maintenant.

Au-delà de sa position de fabricant, Gemalto est aussi un véritable partenaire de l'opération, développant les services demandés par les utilisateurs. Et ceux-ci sont nombreux : cette carte d'étudiant intelligente sert non seulement pour l'identification mais peut aussi se transformer, selon les universités, en porte-monnaie électronique (pour les achats sur des distributeurs, pour les transports, les cantines...), en dispositif de contrôle d'accès (aux locaux, aux parkings, aux ordinateurs et kiosques en libre service...), en clé de signature électronique (pour la transmission sécurisée de mails et documents dématérialisés, pour des votes électroniques...), en carte de "pointage" et de contrôle des horaires...

Naturellement, la banque propose aussi, en option, d'ajouter à cette liste la fonction de carte bancaire, au standard EMV. En effet, il existe bien un objectif commercial derrière cette démarche : celui de se positionner au plus près du marché attractif des étudiants et d'imposer sa présence dans les universités partenaires.

Les cartes de Gemalto sont relativement classiques, disposant d'une puce sécurisée et d'une interface MiFare (un des standards de communication sans contact de la sphère NFC) et programmables via une interface Java. Pour l'avenir, Santander et Gemalto réfléchissent à l'intégration des mêmes fonctions dans les téléphones portables, quelques expérimentations ayant déjà été lancées.

La carte bancaire ISIC (carte internationale d'étudiant) lancée à grand renfort de communication par LCL l'an dernier (je crois) fait un peu pâle figure en comparaison de cette initiative de Santander...

mardi 28 décembre 2010

Les applications mobiles d'ING Direct confortent sa stratégie en ligne

ComputerWorld présente un article à propos de la stratégie mobile d'ING Direct (USA), donnant également un aperçu inédit des "dessous" des applications pour smartphones de la banque.

Rudy Wolfs, DSI d'ING Direct, pense que d'ici 5 ans, la majorité des consommateurs ne possèdera plus de PC, utilisant celui de leur travail en cas de nécessité, et comptera surtout sur des appareils mobiles versatiles pour tous les besoins courants d'interactions en ligne. Dans ces conditions, il n'est pas étonnant que la banque prenne très au sérieux sa stratégie mobile !

Les récents succès de ses applications (300 000 téléchargements pour 7,5 millions de clients) poussent ING Direct à réaffirmer sa volonté de ne pas développer de réseau d'agences, et profiter de son modèle en ligne (avec tout de même un réseau très étendu de guichets automatiques) et de ses faibles coûts de structure pour proposer des taux avantageux et offrir des services à petits prix.

Les applications développées par la banque sont à la hauteur de ses ambitions. Disponibles pour iPhone, BlackBerry et, plus récemment, Android, elles donnent non seulement un accès aux fonctions bancaires classiques (consultation des soldes et des opérations, paiement de factures, virements...) mais intègrent également les applications "sociales" d'ING Direct, de manière ludique, avec "Flip for Fun" qui permet d'accéder directement aux pages Facebook et Twitter de la banque ainsi qu'à son blog "We, the Savers Blog" en "renversant" le téléphone. Une application distincte, ING ShareBuilder, offre en outre tous les outils nécessaires pour investir et gérer un portefeuille de valeurs.

Sans donner plus de détails, Rudy Wolfs révèle que le coût de ces applications s'élève à plusieurs millions de dollars, dont une bonne part a certainement été réservée à la conception, qui s'est étalée sur plus d'un an alors que le développement proprement dit n'a duré que 4 mois.

ING Direct a retenu Antenna Mobility Platform, d'Antenna Software, pour bâtir sa stratégie. Cette plate-forme offre une compatibilité étendue avec de multiples systèmes mobiles, via des applications natives (Android, iPhone, BlackBerry...) ou web, facilitant le déploiement des mêmes fonctions sur les différents téléphones du marché. Grâce à ses composantes "serveurs" dédiées (en mode SaaS, "Software as a Service"), l'infrastructure d'Antenna assure la robustesse de l'architecture face à une charge parfois difficile à prédire et que les systèmes internes des banques ne sont pas toujours capables de supporter aisément.

En conclusion, je m'étonnerai tout de même des coûts de mise en oeuvre évoqués (même approximatifs), dont il nous est assuré que l'investissement dans la plate-forme d'Antenna n'est qu'une toute petite partie. Ils tendent à relativiser fortement l'intérêt des solutions de développement mobile "universel", d'autant plus quand on réalise que la version Android de l'application d'ING Direct n'a été publiée que 4 mois après la version iPhone... Les promesses de développement rapide, économique et portable semblent un peu exagérées !

Rudy Wolfs, DSI d'ING Direct, pense que d'ici 5 ans, la majorité des consommateurs ne possèdera plus de PC, utilisant celui de leur travail en cas de nécessité, et comptera surtout sur des appareils mobiles versatiles pour tous les besoins courants d'interactions en ligne. Dans ces conditions, il n'est pas étonnant que la banque prenne très au sérieux sa stratégie mobile !

Les récents succès de ses applications (300 000 téléchargements pour 7,5 millions de clients) poussent ING Direct à réaffirmer sa volonté de ne pas développer de réseau d'agences, et profiter de son modèle en ligne (avec tout de même un réseau très étendu de guichets automatiques) et de ses faibles coûts de structure pour proposer des taux avantageux et offrir des services à petits prix.

Les applications développées par la banque sont à la hauteur de ses ambitions. Disponibles pour iPhone, BlackBerry et, plus récemment, Android, elles donnent non seulement un accès aux fonctions bancaires classiques (consultation des soldes et des opérations, paiement de factures, virements...) mais intègrent également les applications "sociales" d'ING Direct, de manière ludique, avec "Flip for Fun" qui permet d'accéder directement aux pages Facebook et Twitter de la banque ainsi qu'à son blog "We, the Savers Blog" en "renversant" le téléphone. Une application distincte, ING ShareBuilder, offre en outre tous les outils nécessaires pour investir et gérer un portefeuille de valeurs.

Sans donner plus de détails, Rudy Wolfs révèle que le coût de ces applications s'élève à plusieurs millions de dollars, dont une bonne part a certainement été réservée à la conception, qui s'est étalée sur plus d'un an alors que le développement proprement dit n'a duré que 4 mois.

ING Direct a retenu Antenna Mobility Platform, d'Antenna Software, pour bâtir sa stratégie. Cette plate-forme offre une compatibilité étendue avec de multiples systèmes mobiles, via des applications natives (Android, iPhone, BlackBerry...) ou web, facilitant le déploiement des mêmes fonctions sur les différents téléphones du marché. Grâce à ses composantes "serveurs" dédiées (en mode SaaS, "Software as a Service"), l'infrastructure d'Antenna assure la robustesse de l'architecture face à une charge parfois difficile à prédire et que les systèmes internes des banques ne sont pas toujours capables de supporter aisément.

En conclusion, je m'étonnerai tout de même des coûts de mise en oeuvre évoqués (même approximatifs), dont il nous est assuré que l'investissement dans la plate-forme d'Antenna n'est qu'une toute petite partie. Ils tendent à relativiser fortement l'intérêt des solutions de développement mobile "universel", d'autant plus quand on réalise que la version Android de l'application d'ING Direct n'a été publiée que 4 mois après la version iPhone... Les promesses de développement rapide, économique et portable semblent un peu exagérées !

lundi 27 décembre 2010

Carbon Hub aligne son modèle économique sur la taxe carbone

Profitant de la transformation du système britannique de compensation des émissions de gaz à effet de serre (GES) en une pure "taxe carbone", Carbon Hub, fournisseur de solutions de suivi et de gestion de l'impact environnemental des entreprises, propose [lien PDF] un nouveau modèle économique aux organisations concernées, qui permettra à celles-ci de payer une partie des économies qu'elles réaliseront en guise de licence.

La nouvelle réglementation, qui entre en vigueur à partir de 2011 sous le nom de "Carbon Reduction Commitment Energy Efficiency Scheme" (CRC) vise les quelques 4000 plus grandes entreprises et établissements publics britanniques, qui devront "compenser" leur émissions de GES par l'achat obligatoire de "crédits" dont le prix est fixé initialement à 12 £ par tonne d'équivalent CO2.

C'est à ces organisations que s'adresse la nouvelle offre de Carbon Hub : elles peuvent rejoindre librement et gratuitement le "hub" et ne paieront qu'une fraction des crédits qu'elles économiseront pour continuer à l'utiliser. Pour plus de sécurité, l'éditeur garantit qu'il adoptera les critères du CRC pour ses mesures d'émissions de GES et qu'il adaptera son mode de facturation à l'évolution de la réglementation.

Carbon Hub innove réellement avec son approche, qui ne manque pas de bon sens, bien que j'imagine qu'il puisse donner des migraines à quelques comptables. L'initiative est d'autant plus audacieuse pour un fournisseur de solutions de gestion des émissions de GES, qui peut difficilement garantir une réduction de ces émissions.

On l'attendrait plus (et on l'attend désormais !), par exemple, d'une société, comme 1E ou AVOB (ou les nombreuses autres), qui promet une baisse de la facture électrique par l'optimisation de l'alimentation des PCs. On se prendrait même à rêver d'une généralisation de ce modèle à tous les éditeurs qui vantent les réductions de coûts ou les améliorations de productivité apportées par leurs logiciels...

Pointeur glané sur GreenIT.fr (merci !)

La nouvelle réglementation, qui entre en vigueur à partir de 2011 sous le nom de "Carbon Reduction Commitment Energy Efficiency Scheme" (CRC) vise les quelques 4000 plus grandes entreprises et établissements publics britanniques, qui devront "compenser" leur émissions de GES par l'achat obligatoire de "crédits" dont le prix est fixé initialement à 12 £ par tonne d'équivalent CO2.

C'est à ces organisations que s'adresse la nouvelle offre de Carbon Hub : elles peuvent rejoindre librement et gratuitement le "hub" et ne paieront qu'une fraction des crédits qu'elles économiseront pour continuer à l'utiliser. Pour plus de sécurité, l'éditeur garantit qu'il adoptera les critères du CRC pour ses mesures d'émissions de GES et qu'il adaptera son mode de facturation à l'évolution de la réglementation.

Au-delà de son modèle économique original, la plate-forme de la jeune société (fondée à Londres par deux français) mérite également qu'on s'y attarde. Comptant parmi ses références une filiale de la Caisse des Dépôts et le Crédit Agricole d'Ille-et-Villaine, elle propose une solution relativement classique de suivi et de gestion des émissions de GES (en mode SaaS - Software as a Service) complétée d'une composante collaborative unique dans le domaine. Celle-ci permet à tous les utilisateurs d'échanger des bonnes pratiques, partager des documents et des expériences, développer des réseaux de participants, au sein de chaque entreprise cliente mais aussi entre entreprises...

Carbon Hub innove réellement avec son approche, qui ne manque pas de bon sens, bien que j'imagine qu'il puisse donner des migraines à quelques comptables. L'initiative est d'autant plus audacieuse pour un fournisseur de solutions de gestion des émissions de GES, qui peut difficilement garantir une réduction de ces émissions.

On l'attendrait plus (et on l'attend désormais !), par exemple, d'une société, comme 1E ou AVOB (ou les nombreuses autres), qui promet une baisse de la facture électrique par l'optimisation de l'alimentation des PCs. On se prendrait même à rêver d'une généralisation de ce modèle à tous les éditeurs qui vantent les réductions de coûts ou les améliorations de productivité apportées par leurs logiciels...

Pointeur glané sur GreenIT.fr (merci !)

jeudi 23 décembre 2010

Le paiement P2P réserve des surprises

Alors que les banques s'intéressent de plus en plus aux services de paiement de personne à personne (P2P), une étude du Mercator Advisory Group (que je ne peux malheureusement pas consulter dans son intégralité) vient à point pour en éclairer les usages et le potentiel. Et les résultats pourront surprendre !

Ainsi, en analysant les retours d'expérience des pionniers du paiement P2P (aux Etats-Unis), le rapport révèle que le montant moyen des échanges est de l'ordre de 200 dollars, soit 10 fois plus que ce qui est généralement attendu par les banques qui lancent ce service. Il s'avère en fait que ces transactions ne se limitent pas à des échanges entre amis ou membres d'une famille mais qu'elles concernent également, pour une large part, des paiements "commerciaux", vers des entrepreneurs individuels ou de petites entreprises (par exemple pour des services à la personne). En ce sens, il conviendrait plutôt de parler de "paiements de pair à pair" plutôt que de "personne à personne".

Ces constats ont des implications profondes. Tout d'abord, le paiement P2P ne se substitue pas uniquement aux échanges en espèces (de personne à personne) mais peut également remplacer les règlements par chèque (de personne à professionnel). De plus, cette typologie des usages laisse penser que les clients des banques ne sont probablement pas opposés à ce que le service leur soit facturé (dans des limites raisonnables), ce qui pourrait résoudre le dilemme des établissements qui ne savent pas encore s'il peut constituer une source de revenus ou s'il n'est qu'un facteur de rétention et de fidélisation de la clientèle.

L'étude du Mercator Advisory Group démontre une nouvelle fois la créativité des consommateurs, qui sont toujours prêts à adopter les services qui leur sont offerts, en inventant les usages répondant à leurs besoins, parfois éloignés de ceux imaginés par les concepteurs.

En tout état de cause, le paiement P2P séduit les consommateurs. Et, comme il semble aussi pouvoir offrir des opportunités de nouveaux revenus pour les banques, il ne reste plus de raisons pour qu'il ne se développe pas aussi en France !

Ainsi, en analysant les retours d'expérience des pionniers du paiement P2P (aux Etats-Unis), le rapport révèle que le montant moyen des échanges est de l'ordre de 200 dollars, soit 10 fois plus que ce qui est généralement attendu par les banques qui lancent ce service. Il s'avère en fait que ces transactions ne se limitent pas à des échanges entre amis ou membres d'une famille mais qu'elles concernent également, pour une large part, des paiements "commerciaux", vers des entrepreneurs individuels ou de petites entreprises (par exemple pour des services à la personne). En ce sens, il conviendrait plutôt de parler de "paiements de pair à pair" plutôt que de "personne à personne".

Ces constats ont des implications profondes. Tout d'abord, le paiement P2P ne se substitue pas uniquement aux échanges en espèces (de personne à personne) mais peut également remplacer les règlements par chèque (de personne à professionnel). De plus, cette typologie des usages laisse penser que les clients des banques ne sont probablement pas opposés à ce que le service leur soit facturé (dans des limites raisonnables), ce qui pourrait résoudre le dilemme des établissements qui ne savent pas encore s'il peut constituer une source de revenus ou s'il n'est qu'un facteur de rétention et de fidélisation de la clientèle.

L'étude du Mercator Advisory Group démontre une nouvelle fois la créativité des consommateurs, qui sont toujours prêts à adopter les services qui leur sont offerts, en inventant les usages répondant à leurs besoins, parfois éloignés de ceux imaginés par les concepteurs.

En tout état de cause, le paiement P2P séduit les consommateurs. Et, comme il semble aussi pouvoir offrir des opportunités de nouveaux revenus pour les banques, il ne reste plus de raisons pour qu'il ne se développe pas aussi en France !

lundi 20 décembre 2010

LG et VMWare virtualisent le mobile pour sécuriser les usages professionnels

Toutes les études l'annoncent (par exemple ici) et tous les DSI y sont confrontés à plus ou moins grande échelle : les collaborateurs des entreprises sont de plus en plus nombreux à utiliser leur PC, tablette ou smartphone personnel pour leurs besoins professionnels, créant un casse-tête pour les responsables de la sécurité qui voient s'évanouir les "murs" de protection qu'ils ont mis en place pour protéger les données et les communications de l'entreprise.

Pour les aider dans leur tâche, VMWare et LG ont annoncé un partenariat pour créer une plate-forme de virtualisation pour mobile, qui permettra aux entreprises d'offrir à leurs employés un environnement professionnel totalement sécurisé sur leur téléphone personnel.

Comme dans le cas des initiatives équivalentes sur PC, la DSI pourrait ainsi fournir aux collaborateurs une machine virtuelle à installer sur leur propre mobile, leur donnant accès aux logiciels et services internes (stockage et consultation de documents, messagerie, outils collaboratifs...). Cette machine virtuelle est totalement isolée de l'environnement "personnel" présent sur le téléphone et peut accueillir toutes les couches de sécurité et de protection "standards" de l'organisation (logiciels de chiffrage, mécanismes de désactivation à distance, restrictions d'utilisation...).

Les efforts de VMWare et LG porteront, dans un premier temps, sur la plate-forme Android de Google, dont l'ouverture (puisque le système est disponible en open source) leur facilitera la tâche. L'objectif reste tout de même d'offrir à terme une couverture du marché la plus large possible, pour adresser les besoins d'un maximum d'utilisateurs.

Le concept de la machine virtuelle "professionnel" isolée et sécurisée est séduisant pour répondre aux risques introduits par l'usage de smartphones personnels en entreprise. Pourtant, entre la théorie et l'exécution il restera un long chemin à parcourir. La fragmentation du marché du mobile (en termes de systèmes d'exploitation) rendra en effet la généralisation complexe (on peut notamment douter de la faisabilité sur la plate-forme fermée iOS d'Apple).

De plus, le fait que l'initiative annoncée par VMWare soit co-réalisée avec le constructeur LG laisse imaginer que ce dernier pourrait vouloir réserver la technologie à ses propres matériels, ce qui serait contradictoire avec l'objectif de couvrir les besoins de tous les utilisateurs, quel que soit leur choix d'appareil. Mais on peut tout de même espérer que VMWare est conscient de ces enjeux et que l'éditeur cherche surtout à "lancer" la tendance avec ce premier partenaire.

Pour les aider dans leur tâche, VMWare et LG ont annoncé un partenariat pour créer une plate-forme de virtualisation pour mobile, qui permettra aux entreprises d'offrir à leurs employés un environnement professionnel totalement sécurisé sur leur téléphone personnel.

Comme dans le cas des initiatives équivalentes sur PC, la DSI pourrait ainsi fournir aux collaborateurs une machine virtuelle à installer sur leur propre mobile, leur donnant accès aux logiciels et services internes (stockage et consultation de documents, messagerie, outils collaboratifs...). Cette machine virtuelle est totalement isolée de l'environnement "personnel" présent sur le téléphone et peut accueillir toutes les couches de sécurité et de protection "standards" de l'organisation (logiciels de chiffrage, mécanismes de désactivation à distance, restrictions d'utilisation...).

Les efforts de VMWare et LG porteront, dans un premier temps, sur la plate-forme Android de Google, dont l'ouverture (puisque le système est disponible en open source) leur facilitera la tâche. L'objectif reste tout de même d'offrir à terme une couverture du marché la plus large possible, pour adresser les besoins d'un maximum d'utilisateurs.

Le concept de la machine virtuelle "professionnel" isolée et sécurisée est séduisant pour répondre aux risques introduits par l'usage de smartphones personnels en entreprise. Pourtant, entre la théorie et l'exécution il restera un long chemin à parcourir. La fragmentation du marché du mobile (en termes de systèmes d'exploitation) rendra en effet la généralisation complexe (on peut notamment douter de la faisabilité sur la plate-forme fermée iOS d'Apple).

De plus, le fait que l'initiative annoncée par VMWare soit co-réalisée avec le constructeur LG laisse imaginer que ce dernier pourrait vouloir réserver la technologie à ses propres matériels, ce qui serait contradictoire avec l'objectif de couvrir les besoins de tous les utilisateurs, quel que soit leur choix d'appareil. Mais on peut tout de même espérer que VMWare est conscient de ces enjeux et que l'éditeur cherche surtout à "lancer" la tendance avec ce premier partenaire.

dimanche 19 décembre 2010

Nouvelles applications iPad pour BNP Paribas Fortis et BofA Merrill Lynch

Après la frénésie des applications pour iPhone, les banques commencent à développer leurs offres pour l'iPad, essayant de profiter des caractéristiques particulières de la tablette d'Apple pour de nouveaux usages.

Dans ce domaine, la dernière annonce de Bank of America Merrill Lynch semble confirmer la tendance actuelle, esquissée par les exemples de Citi, JP Morgan et quelques autres, de proposer aux clients des contenus et non plus des outils de gestion de comptes. Et, alors que ces premières initiatives s'adressent aux clients institutionnels ou de banque privée, BNP Paribas Fortis adopte maintenant une stratégie similaire dans la banque de détail.

Commençons par la Bank of America Merrill Lynch Global Research dont l'application, "Research Library", propose à ses clients institutionnels un accès à l'ensemble de ses analyses, études, rapports, recommandations et autres contenus produits par ses plus de 800 analystes à travers le monde.

Ces informations sont présentées à travers un certain nombre de "widgets", organisés par catégorie de valeurs, par industrie, par analyste..., permettant une personnalisation de l'expérience par l'utilisateur. Les capacités de la tablette sont mises à profit pour intégrer des contenus multimédias (graphiques et vidéos, notamment). Des alertes, ciblées, lors des nouvelles publications complètent la liste des fonctions offertes.

On peut néanmoins regretter qu'une bonne partie des contenus proposés ne soient en fait que de simples documents PDF, dont l'intégration dans l'application ne sera donc pas idéale...

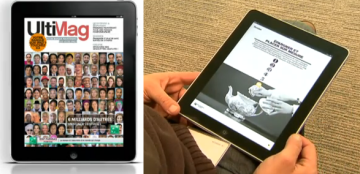

Pour BNP Paribas Fortis (Belgique), UltiMag se présente comme un magazine proposant à tous ses clients particuliers des articles variés, non seulement sur les produits et services de la banque mais également sur des sujets plus généralistes, relatifs à la finance ou non (par exemple, sur des activités dont la banque est sponsor ou mécène).

Conçu comme une véritable revue interactive, les articles sélectionnés sont enrichis de contenus multimédias (vidéos, illustrations, témoignages...). Un accès direct à la banque en ligne est également intégré dans l'application.

La première vague d'applications pour iPad, que j'estime décevante, n'avait vu apparaître que des copies des logiciels de gestion de compte déjà proposés sur l'iPhone et, souvent, sans gros effort pour exploiter les possibilités de la tablette. La deuxième vague, que l'on voit donc émerger, est beaucoup plus intéressante puisqu'elle nous propose des applications qui n'existaient pas jusqu'à maintenant et qui sont parfaitement adaptées à l'usage principal de l'appareil, tel qu'il est observé sur le terrain : la consommation de contenus (par opposition à des outils transactionnels).

Par ailleurs, alors que les premières initiatives ciblaient "naturellement" les clients "haut de gamme", la démarche de BNP Paribas Fortis, qui veut s'adresser aux particuliers, est plus risquée puisqu'elle a peu de chances de toucher un large public. Cependant, le segment de clientèle possédant un iPad mérite certainement des attentions particulières, ce qui pourrait révéler une stratégie payante à moyen terme. Il reste tout de même à espérer qu'avec l'explosion attendue (en 2011) du marché des tablettes, la banque soit capable de proposer son application sur d'autres systèmes que celui d'Apple...

Dans ce domaine, la dernière annonce de Bank of America Merrill Lynch semble confirmer la tendance actuelle, esquissée par les exemples de Citi, JP Morgan et quelques autres, de proposer aux clients des contenus et non plus des outils de gestion de comptes. Et, alors que ces premières initiatives s'adressent aux clients institutionnels ou de banque privée, BNP Paribas Fortis adopte maintenant une stratégie similaire dans la banque de détail.

Commençons par la Bank of America Merrill Lynch Global Research dont l'application, "Research Library", propose à ses clients institutionnels un accès à l'ensemble de ses analyses, études, rapports, recommandations et autres contenus produits par ses plus de 800 analystes à travers le monde.

Ces informations sont présentées à travers un certain nombre de "widgets", organisés par catégorie de valeurs, par industrie, par analyste..., permettant une personnalisation de l'expérience par l'utilisateur. Les capacités de la tablette sont mises à profit pour intégrer des contenus multimédias (graphiques et vidéos, notamment). Des alertes, ciblées, lors des nouvelles publications complètent la liste des fonctions offertes.

On peut néanmoins regretter qu'une bonne partie des contenus proposés ne soient en fait que de simples documents PDF, dont l'intégration dans l'application ne sera donc pas idéale...

Pour BNP Paribas Fortis (Belgique), UltiMag se présente comme un magazine proposant à tous ses clients particuliers des articles variés, non seulement sur les produits et services de la banque mais également sur des sujets plus généralistes, relatifs à la finance ou non (par exemple, sur des activités dont la banque est sponsor ou mécène).

Conçu comme une véritable revue interactive, les articles sélectionnés sont enrichis de contenus multimédias (vidéos, illustrations, témoignages...). Un accès direct à la banque en ligne est également intégré dans l'application.

La première vague d'applications pour iPad, que j'estime décevante, n'avait vu apparaître que des copies des logiciels de gestion de compte déjà proposés sur l'iPhone et, souvent, sans gros effort pour exploiter les possibilités de la tablette. La deuxième vague, que l'on voit donc émerger, est beaucoup plus intéressante puisqu'elle nous propose des applications qui n'existaient pas jusqu'à maintenant et qui sont parfaitement adaptées à l'usage principal de l'appareil, tel qu'il est observé sur le terrain : la consommation de contenus (par opposition à des outils transactionnels).

Par ailleurs, alors que les premières initiatives ciblaient "naturellement" les clients "haut de gamme", la démarche de BNP Paribas Fortis, qui veut s'adresser aux particuliers, est plus risquée puisqu'elle a peu de chances de toucher un large public. Cependant, le segment de clientèle possédant un iPad mérite certainement des attentions particulières, ce qui pourrait révéler une stratégie payante à moyen terme. Il reste tout de même à espérer qu'avec l'explosion attendue (en 2011) du marché des tablettes, la banque soit capable de proposer son application sur d'autres systèmes que celui d'Apple...

samedi 18 décembre 2010

Brett King : les 14 innovations de l'année dans la finance

En dehors des prédictions pour l'année suivante, l'autre tradition de fin d'année est celle des rétrospectives. Ainsi Brett King, auteur de "Bank 2.0" nous livre sa sélection des 14 meilleures innovations dans la banque et les paiements pour 2010, toutes rendues possibles par les technologies actuelles.

Agence du futur de Citi. Initiative maintenant répliquée à New York, c'est d'abord à Shanghaï que Citi a lancé son nouveau concept d'agence, inspiré par les Apple Stores.

Dépôt de chèque par mobile pour USAA. Copié par de nombreuses autres banques depuis son lancement, USAA a été la première aux Etats-Unis à proposer le dépôt de chèque via une application iPhone et Android, rendu possible par la législation locale. Loin d'en rester là, la banque a ensuite exploité sa technologie pour offrir à ses clients des services de proximité dans les agences UPS.

Guichet automatique de BBVA. Renouvelant le classique guichet automatique (ATM), BBVA et son partenaire IDEO ont conçu leur distributeur en écoutant les clients de la banque. Le résultat se veut plus simple, plus intuitif et plus convivial, avec un grand écran tactile ressemblant un peu à un iPad.

Application iPad d'OCBC. Alors que la plupart des banques se sont contentées, au mieux, d'adapter leur application iPhone à la taille de l'écran de l'iPad, OCBC est l'un des rares établissements à avoir réalisé une version mettant à profit les caractéristiques de la tablette d'Apple, en particulier avec des fonctions de suivi de budget graphiques et riches.

M-Pesa, et la banque devient mobile. Après avoir révolutionné les paiements par mobile avec M-Pesa, l'opérateur kenyan Safaricom poursuit le développement de son service en proposant le retrait d'espèces avec son téléphone sur les distributeurs de deux banques partenaires.

Google adopte le sans contact. Le paiement sans contact sur téléphone mobile est annoncé comme la prochaine "révolution" depuis presque 10 ans, mais la généralisation tarde... Google vient secouer le marché en intégrant la technologie NFC dans son système Android et dans son propre téléphone, le Nexus S.

Faible latence. Malgré le "flash crash" du 6 mai, partiellement imputé aux systèmes de trading automatisés, 2010 restera comme l'année de la course à la latence, pour réaliser des opérations sur les marchés en des temps toujours plus courts, aujourd'hui mesurés en microsecondes.

Prêts-emprunts P2P. Ils existent depuis plusieurs années mais ils s'incrustent désormais dans le paysage de la finance, les sites de prêts-emprunts de particulier à particulier (P2P), comme LendingClub ou Zopa, font leur pub et "gèrent" des dizaines de millions de dollars chaque mois. Malheureusement, cette tendance n'a toujours pas percé en France...

Facebook Credits. Avec ses 500 millions d'utilisateurs à travers le monde et l'évolution de sa monnaie virtuelle, qui pourra bientôt être achetée dans les grandes chaines de distribution américaines, Facebook est peut-être en train de créer la première monnaie universelle...

Charité sur mobile. Après le tremblement de terre à Haïti, les applications mobiles de la Croix Rouge américaine ont permis de recueillir plus de 10 millions de dollars de donations en quelques jours, établissant définitivement le mobile comme un canal majeur pour les efforts de charité.

Progression du PFM. La gestion de finances personnelles (PFM ou Personal Finance Management) a vécu une année marquée par la disparition de Wesabe et le rachat, inquiétant au premier abord, de Mint par Intuit. Mais le PFM est en passe de devenir une fonction incontournable pour les banques, s'immisçant rapidement dans les solutions progicielles et dans la banque en ligne.

Démonstration hi-tech de Santander. Dans une pure démonstration technologique, Santander a créé un "centre visiteurs" offrant des expériences de réalité augmentée, des murs d'écrans tactiles interactifs, des robots pour guider l'utilisateur (image ci-dessus)...

North Shore Bank et la géolocalisation. Petite banque communautaire du Wisconson, North Shore Bank est la première à avoir utilisé le jeu à base de géolocalisation FourSquare dans une opération de communication. En devenant "major" de leur agence (c'est-à-dire en enregistrant le maximum de "check-ins"), les clients pouvaient recevoir des offres promotionnelles.

Square. Parmi de multiples initiatives visant le même objectif, Square restera la start-up qui a réellement inventé le terminal de paiement sur mobile, avec son application et son petit accessoire de lecture de piste magnétique pour iPhone et Android. Avec Square, pour la première fois, tous les commerçants, réguliers ou occasionnels, fixes ou ambulants, peuvent accepter les paiements par carte.

Merci à @WilliamDeckers pour le pointeur !

Agence du futur de Citi. Initiative maintenant répliquée à New York, c'est d'abord à Shanghaï que Citi a lancé son nouveau concept d'agence, inspiré par les Apple Stores.

Dépôt de chèque par mobile pour USAA. Copié par de nombreuses autres banques depuis son lancement, USAA a été la première aux Etats-Unis à proposer le dépôt de chèque via une application iPhone et Android, rendu possible par la législation locale. Loin d'en rester là, la banque a ensuite exploité sa technologie pour offrir à ses clients des services de proximité dans les agences UPS.

Guichet automatique de BBVA. Renouvelant le classique guichet automatique (ATM), BBVA et son partenaire IDEO ont conçu leur distributeur en écoutant les clients de la banque. Le résultat se veut plus simple, plus intuitif et plus convivial, avec un grand écran tactile ressemblant un peu à un iPad.

Application iPad d'OCBC. Alors que la plupart des banques se sont contentées, au mieux, d'adapter leur application iPhone à la taille de l'écran de l'iPad, OCBC est l'un des rares établissements à avoir réalisé une version mettant à profit les caractéristiques de la tablette d'Apple, en particulier avec des fonctions de suivi de budget graphiques et riches.

M-Pesa, et la banque devient mobile. Après avoir révolutionné les paiements par mobile avec M-Pesa, l'opérateur kenyan Safaricom poursuit le développement de son service en proposant le retrait d'espèces avec son téléphone sur les distributeurs de deux banques partenaires.

Google adopte le sans contact. Le paiement sans contact sur téléphone mobile est annoncé comme la prochaine "révolution" depuis presque 10 ans, mais la généralisation tarde... Google vient secouer le marché en intégrant la technologie NFC dans son système Android et dans son propre téléphone, le Nexus S.

Faible latence. Malgré le "flash crash" du 6 mai, partiellement imputé aux systèmes de trading automatisés, 2010 restera comme l'année de la course à la latence, pour réaliser des opérations sur les marchés en des temps toujours plus courts, aujourd'hui mesurés en microsecondes.

Prêts-emprunts P2P. Ils existent depuis plusieurs années mais ils s'incrustent désormais dans le paysage de la finance, les sites de prêts-emprunts de particulier à particulier (P2P), comme LendingClub ou Zopa, font leur pub et "gèrent" des dizaines de millions de dollars chaque mois. Malheureusement, cette tendance n'a toujours pas percé en France...

Facebook Credits. Avec ses 500 millions d'utilisateurs à travers le monde et l'évolution de sa monnaie virtuelle, qui pourra bientôt être achetée dans les grandes chaines de distribution américaines, Facebook est peut-être en train de créer la première monnaie universelle...

Charité sur mobile. Après le tremblement de terre à Haïti, les applications mobiles de la Croix Rouge américaine ont permis de recueillir plus de 10 millions de dollars de donations en quelques jours, établissant définitivement le mobile comme un canal majeur pour les efforts de charité.

Progression du PFM. La gestion de finances personnelles (PFM ou Personal Finance Management) a vécu une année marquée par la disparition de Wesabe et le rachat, inquiétant au premier abord, de Mint par Intuit. Mais le PFM est en passe de devenir une fonction incontournable pour les banques, s'immisçant rapidement dans les solutions progicielles et dans la banque en ligne.

Démonstration hi-tech de Santander. Dans une pure démonstration technologique, Santander a créé un "centre visiteurs" offrant des expériences de réalité augmentée, des murs d'écrans tactiles interactifs, des robots pour guider l'utilisateur (image ci-dessus)...

North Shore Bank et la géolocalisation. Petite banque communautaire du Wisconson, North Shore Bank est la première à avoir utilisé le jeu à base de géolocalisation FourSquare dans une opération de communication. En devenant "major" de leur agence (c'est-à-dire en enregistrant le maximum de "check-ins"), les clients pouvaient recevoir des offres promotionnelles.

Square. Parmi de multiples initiatives visant le même objectif, Square restera la start-up qui a réellement inventé le terminal de paiement sur mobile, avec son application et son petit accessoire de lecture de piste magnétique pour iPhone et Android. Avec Square, pour la première fois, tous les commerçants, réguliers ou occasionnels, fixes ou ambulants, peuvent accepter les paiements par carte.

Merci à @WilliamDeckers pour le pointeur !

Chase et IHG créent une carte privative avec leurs meilleurs clients

Le creux d'actualités qui se dessine en cette fin d'année me permet de revenir sur quelques sujets "oubliés" les mois derniers. Ainsi, parmi les initiatives distinguées par un "Forrester Groundswell Award" en octobre, celle de Chase mérite un coup de projecteur.

Lorsqu'en juin 2009 InterContinental Hotel Group (IHG) et Chase Card Services ont décidé de renouveler leur offre de carte privative, leur volonté était de concevoir un produit qui soit en réelle adéquation avec les attentes de leur clientèle. Pour atteindre cet objectif, une communauté de 300 clients soigneusement sélectionnés (participants actifs au programme de fidélité d'IHG et porteurs de la carte existante) a été constituée et une plate-forme collaborative privée mise en place.

Celle-ci, basée sur la solution de Communispace, offrait aux organisateurs les moyens de solliciter les avis et d'écouter les participants, à travers des enquêtes en ligne, des discussions, des galeries de photos, des dialogues ouverts entre membres... Elle a permis de recueillir des informations préciseuses sur ce qui motive le choix d'une carte de crédit par rapport à une autre, sur les offres concurrentes, sur les caractéristiques qui les inciteraient à payer une cotisation annuelle... Malgré la petite taille de la communauté, plus de 30 000 contributions (100 par personne, en moyenne !) ont été apportées à la conversation pendant l'année qu'a duré l'opération.

Forts des résultats de cette phase d'écoute, IHG et Chase ont lancé leur nouvelle carte "Priority Club Select" en juin 2010, proposant les caractéristiques les plus demandées (une nuit d'hôtel gratuite chaque année, l'absence de frais pour les transactions à l'étranger...) et offerte à un prix (annuel) de 49 dollars, également "fixé par les clients", comme celui qu'ils étaient prêts à payer pour ces avantages.

Et les efforts semblent payants puisque la première campagne marketing (par mail) pour cette nouvelle carte a généré 80% de plus d'ouvertures de comptes que la précédente (avec l'ancienne carte), y compris parmi une population qui était jusqu'alors réticente à l'idée de payer une cotisation pour une carte de crédit. Un autre bénéfice espéré avec l'ensemble de l'opération, la démarche participative et la nouvelle offre, est de renforcer la fidélité des clients.

Cet exemple est une brillante démonstration de la valeur des démarches de co-innovation qui se développent encore timidement. Pour ma part, j'en retiens deux leçons, qui vont un peu à l'encontre des "normes" du genre : une petite communauté de clients (s'ils sont suffisamment "engagés") peut suffire dans ce genre d'approche et la conversation peut se prolonger dans la durée avant toute concrétisation.

Notons que la plate-forme Communispace était présente dans une autre initiative, plus ancienne, soumise aux Forrester Groundswell Awards : le "Student Pulse" de Bank of America, dont l'objectif était d'échanger avec une population de collégiens pour accroître la notoriété de la banque, améliorer son image de marque et développer ses activités dans ce segment de clientèle.

Lorsqu'en juin 2009 InterContinental Hotel Group (IHG) et Chase Card Services ont décidé de renouveler leur offre de carte privative, leur volonté était de concevoir un produit qui soit en réelle adéquation avec les attentes de leur clientèle. Pour atteindre cet objectif, une communauté de 300 clients soigneusement sélectionnés (participants actifs au programme de fidélité d'IHG et porteurs de la carte existante) a été constituée et une plate-forme collaborative privée mise en place.

Celle-ci, basée sur la solution de Communispace, offrait aux organisateurs les moyens de solliciter les avis et d'écouter les participants, à travers des enquêtes en ligne, des discussions, des galeries de photos, des dialogues ouverts entre membres... Elle a permis de recueillir des informations préciseuses sur ce qui motive le choix d'une carte de crédit par rapport à une autre, sur les offres concurrentes, sur les caractéristiques qui les inciteraient à payer une cotisation annuelle... Malgré la petite taille de la communauté, plus de 30 000 contributions (100 par personne, en moyenne !) ont été apportées à la conversation pendant l'année qu'a duré l'opération.

Forts des résultats de cette phase d'écoute, IHG et Chase ont lancé leur nouvelle carte "Priority Club Select" en juin 2010, proposant les caractéristiques les plus demandées (une nuit d'hôtel gratuite chaque année, l'absence de frais pour les transactions à l'étranger...) et offerte à un prix (annuel) de 49 dollars, également "fixé par les clients", comme celui qu'ils étaient prêts à payer pour ces avantages.

Et les efforts semblent payants puisque la première campagne marketing (par mail) pour cette nouvelle carte a généré 80% de plus d'ouvertures de comptes que la précédente (avec l'ancienne carte), y compris parmi une population qui était jusqu'alors réticente à l'idée de payer une cotisation pour une carte de crédit. Un autre bénéfice espéré avec l'ensemble de l'opération, la démarche participative et la nouvelle offre, est de renforcer la fidélité des clients.

Cet exemple est une brillante démonstration de la valeur des démarches de co-innovation qui se développent encore timidement. Pour ma part, j'en retiens deux leçons, qui vont un peu à l'encontre des "normes" du genre : une petite communauté de clients (s'ils sont suffisamment "engagés") peut suffire dans ce genre d'approche et la conversation peut se prolonger dans la durée avant toute concrétisation.

Notons que la plate-forme Communispace était présente dans une autre initiative, plus ancienne, soumise aux Forrester Groundswell Awards : le "Student Pulse" de Bank of America, dont l'objectif était d'échanger avec une population de collégiens pour accroître la notoriété de la banque, améliorer son image de marque et développer ses activités dans ce segment de clientèle.

mercredi 15 décembre 2010

S1 invite PayPal dans ses solutions de banque en ligne et mobile

En annonçant un partenariat avec PayPal, l'éditeur de progiciels bancaires S1 esquisse la généralisation du paiement de particulier à particulier (P2P) dans la banque en ligne et mobile. Ce sont les solutions de sa filiale PM Systems Corportation, ciblant les credit unions (les banques coopératives américaines), qui bénéficient pour l'instant de cette nouveauté, déjà retenue par une dizaine de ses clients.

L'option de paiement intégrée garde toute la simplicité du système original de PayPal : une fois connecté sur son site de banque en ligne ou mobile, l'utilisateur n'a plus qu'à fournir le montant à transférer et le numéro de téléphone ou l'adresse mail du destinataire pour réaliser un paiement. Le bénéficiaire reçoit les fonds immédiatement sur son compte PayPal, la création d'un compte lui étant proposée s'il n'en possède pas. La plate-forme de S1 permet à la banque de facturer ou non le service à ses clients, à sa convenance.

Après les premières initiatives individuelles de quelques établissements, cette annonce renforce encore la crédibilité de PayPal comme partenaire des banques. Après une longue période de défiance, à la fois vis-à-vis de la startup souvent perçue comme une concurrente et aussi vis-à-vis du paiement P2P, elles prennent maintenant conscience de l'intérêt qu'elles peuvent avoir à intégrer tous les services financiers au sein de leurs plates-formes de banque à distance.

Par ailleurs, il est révélateur de voir les credit unions prendre de vitesse les grandes institutions, démontrant ainsi encore une fois leur réactivité et leur capacité à répondre aux attentes réelles de leurs clients. Ce constat est d'autant plus visible quand l'innovation ne requiert pas de moyens importants, ce qui est naturellement le cas pour l'intégration des services de PayPal dans un site de banque en ligne ou dans une application mobile.

Les banques françaises, dont celles qui ont lancé leur propre système de paiement P2P (au succès, au mieux, modeste), finiront certainement par rejoindre ce mouvement. Espérons ne pas avoir à attendre trop longtemps...

L'option de paiement intégrée garde toute la simplicité du système original de PayPal : une fois connecté sur son site de banque en ligne ou mobile, l'utilisateur n'a plus qu'à fournir le montant à transférer et le numéro de téléphone ou l'adresse mail du destinataire pour réaliser un paiement. Le bénéficiaire reçoit les fonds immédiatement sur son compte PayPal, la création d'un compte lui étant proposée s'il n'en possède pas. La plate-forme de S1 permet à la banque de facturer ou non le service à ses clients, à sa convenance.

Après les premières initiatives individuelles de quelques établissements, cette annonce renforce encore la crédibilité de PayPal comme partenaire des banques. Après une longue période de défiance, à la fois vis-à-vis de la startup souvent perçue comme une concurrente et aussi vis-à-vis du paiement P2P, elles prennent maintenant conscience de l'intérêt qu'elles peuvent avoir à intégrer tous les services financiers au sein de leurs plates-formes de banque à distance.

Par ailleurs, il est révélateur de voir les credit unions prendre de vitesse les grandes institutions, démontrant ainsi encore une fois leur réactivité et leur capacité à répondre aux attentes réelles de leurs clients. Ce constat est d'autant plus visible quand l'innovation ne requiert pas de moyens importants, ce qui est naturellement le cas pour l'intégration des services de PayPal dans un site de banque en ligne ou dans une application mobile.

Les banques françaises, dont celles qui ont lancé leur propre système de paiement P2P (au succès, au mieux, modeste), finiront certainement par rejoindre ce mouvement. Espérons ne pas avoir à attendre trop longtemps...

mardi 14 décembre 2010

Visa crée une application mobile pour les fêtes

Poursuivant sa stratégie de séduction des consommateurs, comme les autres grands réseaux électroniques de paiements, Visa annonce, juste avant les fêtes de fin d'année, le lancement de son application pour mobile (Android et iPhone) permettant aux porteurs de cartes de la marque (aux Etats-Unis) de bénéficier d'offres promotionnelles sur leurs achats en ligne ou dans des boutiques "physiques".

L'application n'apporte pas de fonctions particulièrement innovantes mais regroupe une combinaison de services intéressante. Les offres délivrées au consommateur peuvent être ciblées, par l'annonceur (les porteurs de carte "Signature" ont par ailleurs accès à des promotions spécifiques) ou selon les préférences de l'utilisateur lui-même, qui peut choisir les catégories qui l'intéressent : vêtements, restaurant, voyage... Les fonctions de géolocalisation des smartphones sont aussi mises à contribution pour faciliter la recherche des boutiques participantes (et des guichets automatiques) à proximité de l'utilisateur.

Pour le lancement de cette nouvelle solution, Visa a recruté 50 commerçants participants, pour l'essentiel des grandes chaînes nationales, mais la liste évolue régulièrement. Par ailleurs, c'est Monitise, spécialiste de la banque et du paiement mobiles, qui fournit la plate-forme technique de l'application.

L'initiative de Visa intéressera naturellement les consommateurs mais les commercçants devraient également y trouver leur compte, avec un nouveau moyen d'atteindre et de fidéliser de nouveaux clients.

Pourquoi nos banques ne nous proposent-elles pas des services similaires ?

L'application n'apporte pas de fonctions particulièrement innovantes mais regroupe une combinaison de services intéressante. Les offres délivrées au consommateur peuvent être ciblées, par l'annonceur (les porteurs de carte "Signature" ont par ailleurs accès à des promotions spécifiques) ou selon les préférences de l'utilisateur lui-même, qui peut choisir les catégories qui l'intéressent : vêtements, restaurant, voyage... Les fonctions de géolocalisation des smartphones sont aussi mises à contribution pour faciliter la recherche des boutiques participantes (et des guichets automatiques) à proximité de l'utilisateur.

Pour le lancement de cette nouvelle solution, Visa a recruté 50 commerçants participants, pour l'essentiel des grandes chaînes nationales, mais la liste évolue régulièrement. Par ailleurs, c'est Monitise, spécialiste de la banque et du paiement mobiles, qui fournit la plate-forme technique de l'application.

L'initiative de Visa intéressera naturellement les consommateurs mais les commercçants devraient également y trouver leur compte, avec un nouveau moyen d'atteindre et de fidéliser de nouveaux clients.

Pourquoi nos banques ne nous proposent-elles pas des services similaires ?

lundi 13 décembre 2010

Etude Accenture : l'impératif du multi-canal dans l'assurance

La dernière édition du magazine "The Point" d'Accenture présente les résultats d'une double étude autour des stratégies multi-canal des compagnies d'assurance. Double car elle a été menée auprès de 3500 consommateurs de 6 pays (dont la France) d'une part et de 125 dirigeants de compagnies d'autre part. Cette analyse croisée permet de montrer l'écart existant entre les attentes des uns et les réponses des autres.

D'un côté, les consommateurs déclarent pour plus de la moitié d'entre eux qu'ils feront le "tour du marché" avant de renouveler leurs contrats ou de souscrire de nouveaux produits d'assurance. Et ils seront 43% à passer par un canal internet dans cette démarche, soit à peine moins que les 49% qui consulteront un agent, sans parler de la frange émergente qui utilisera des services sur mobile. Leurs principaux critères de choix sont, dans l'ordre, la rapidité de traitement des problèmes, la transparence des prix et une gamme de produits précisément ajustée à leurs besoins.

Comment sont positionnées les compagnies d'assurance pour répondre à ces attentes ? En un mot : mal. Côté réactivité et rapidité de traitement des dossiers, 42% ont la capacité de diffuser l'information en temps réel dans les agences, 32% peuvent le faire dans les centres d'appel et 27% en ligne. Le constat est encore plus sombre pour les exigences d'offres personnalisées, seulement 14% des établissements interrogés se déclarant en mesure de proposer des produits, promotions et politiques tarifaires spécifiques par segment de clientèle.

L'intégration des canaux de vente est donc bien un impératif et, selon Accenture, les compagnies les plus performantes l'ont bien compris, puiqu'elles investiront en moyenne 50% de plus que les autres dans ce domaine au cours des 3 prochaines années. Intégration ne veut pour autant pas dire uniformisation : il s'agit également d'identifier les usages et les catégories de clientèle "privilégiés" de chaque canal pour concentrer les efforts sur ceux-ci.

En ce sens, le canal de distribution constitue un nouveau critère de personnalisation aux côtés des traditionnels segments de clients, qui sont pourtant déjà difficiles à identifier, par manque d'information pertinente et d'outils d'analyse puissants et maîtrisés.

Pour les spécialistes d'Accenture, les stratégies des compagnies d'assurance doivent être redéfinies, mettant l'accent sur la multi-canalité, en particulier sur mobile, et la personnalisation des offres. Etant encore peu répandues, ces stratégies offriraient une quasi-garantie de succès auprès des consommateurs, à court terme. Mais elles deviendront rapidement impératives pour la survie des assureurs.

Bien que l'étude d'Accenture traite de l'assurance, je suis convaincu que les mêmes constats et, donc, les mêmes recommandations peuvent aussi s'appliquer dans la banque, qui n'est pas beaucoup plus avancée dans les domaines clés du multi-canal et de la personnalisation...

Merci à Laurent pour le pointeur ;-)

D'un côté, les consommateurs déclarent pour plus de la moitié d'entre eux qu'ils feront le "tour du marché" avant de renouveler leurs contrats ou de souscrire de nouveaux produits d'assurance. Et ils seront 43% à passer par un canal internet dans cette démarche, soit à peine moins que les 49% qui consulteront un agent, sans parler de la frange émergente qui utilisera des services sur mobile. Leurs principaux critères de choix sont, dans l'ordre, la rapidité de traitement des problèmes, la transparence des prix et une gamme de produits précisément ajustée à leurs besoins.

Comment sont positionnées les compagnies d'assurance pour répondre à ces attentes ? En un mot : mal. Côté réactivité et rapidité de traitement des dossiers, 42% ont la capacité de diffuser l'information en temps réel dans les agences, 32% peuvent le faire dans les centres d'appel et 27% en ligne. Le constat est encore plus sombre pour les exigences d'offres personnalisées, seulement 14% des établissements interrogés se déclarant en mesure de proposer des produits, promotions et politiques tarifaires spécifiques par segment de clientèle.

L'intégration des canaux de vente est donc bien un impératif et, selon Accenture, les compagnies les plus performantes l'ont bien compris, puiqu'elles investiront en moyenne 50% de plus que les autres dans ce domaine au cours des 3 prochaines années. Intégration ne veut pour autant pas dire uniformisation : il s'agit également d'identifier les usages et les catégories de clientèle "privilégiés" de chaque canal pour concentrer les efforts sur ceux-ci.

En ce sens, le canal de distribution constitue un nouveau critère de personnalisation aux côtés des traditionnels segments de clients, qui sont pourtant déjà difficiles à identifier, par manque d'information pertinente et d'outils d'analyse puissants et maîtrisés.

Pour les spécialistes d'Accenture, les stratégies des compagnies d'assurance doivent être redéfinies, mettant l'accent sur la multi-canalité, en particulier sur mobile, et la personnalisation des offres. Etant encore peu répandues, ces stratégies offriraient une quasi-garantie de succès auprès des consommateurs, à court terme. Mais elles deviendront rapidement impératives pour la survie des assureurs.

Bien que l'étude d'Accenture traite de l'assurance, je suis convaincu que les mêmes constats et, donc, les mêmes recommandations peuvent aussi s'appliquer dans la banque, qui n'est pas beaucoup plus avancée dans les domaines clés du multi-canal et de la personnalisation...

Merci à Laurent pour le pointeur ;-)

dimanche 12 décembre 2010

New York Life ouvre les réseaux sociaux à ses agents

L'utilisation des réseaux sociaux est encore souvent limitée au sein des institutions financières, par crainte de comportements inappropriés, débordements, pertes de productivité, risques pour la sécurité... Quelques entreprises pionnières ayant "ouvert les vannes" ont démontré que les réticences n'étaient pas très justifiées mais, pour les autres, l'assureur New York Life donne un exemple un peu différent.

Reconnaissant la popularité des réseaux sociaux et souhaitant les intégrer dans son métier, sans pour autant prendre de risque avec son image et avec la législation, New York Life a choisi de déployer la solution Compass de Socialware, auprès d'une population pilote (pour l'instant) de 750 agents.

Avec cette plate-forme, les collaborateurs peuvent accéder aux réseaux sociaux publics (Facebook, Twitter, LinkedIn...) et participer aux conversations des internautes. Mais l'entreprise contrôle les règles du jeu : l'administrateur peut limiter les fonctions accessibles et définir des filtres sur les messages postés. De plus, tous les échanges sont archivés et peuvent être facilement recherchés, ce qui permettra de répondre aux exigences réglementaires strictes qui touchent certains métiers de la finance.

Le contrôle permanent des collaborateurs n'est probablement pas la solution idéale pour l'engagement des entreprises sur le web social mais la solution de Socialware a au moins le mérite de retirer un argument aux opposants. Les institutions financières n'auront bientôt plus aucune excuse pour rester à l'écart des réseaux sociaux !

Reconnaissant la popularité des réseaux sociaux et souhaitant les intégrer dans son métier, sans pour autant prendre de risque avec son image et avec la législation, New York Life a choisi de déployer la solution Compass de Socialware, auprès d'une population pilote (pour l'instant) de 750 agents.

Avec cette plate-forme, les collaborateurs peuvent accéder aux réseaux sociaux publics (Facebook, Twitter, LinkedIn...) et participer aux conversations des internautes. Mais l'entreprise contrôle les règles du jeu : l'administrateur peut limiter les fonctions accessibles et définir des filtres sur les messages postés. De plus, tous les échanges sont archivés et peuvent être facilement recherchés, ce qui permettra de répondre aux exigences réglementaires strictes qui touchent certains métiers de la finance.

Le contrôle permanent des collaborateurs n'est probablement pas la solution idéale pour l'engagement des entreprises sur le web social mais la solution de Socialware a au moins le mérite de retirer un argument aux opposants. Les institutions financières n'auront bientôt plus aucune excuse pour rester à l'écart des réseaux sociaux !

Salesforce lance le SGBDR dans le nuage

Fort de l'expérience acquise avec ses applications en SaaS (Software as a Service) stockant 20 milliards d'enregistrements et gérant 25 milliards de transactions par trimestre (plus de 3000 par seconde !), Salesforce lance Database.com, une base de données relationnelle (SGBDR) dans le cloud.

A la différence de la plupart des solutions existantes, Database.com n'est ni une instance de SGBDR dans un nuage d'infrastructure (qu'il faut donc administrer), ni un système de stockage spécifique à l'architecture en cloud (avec leurs modèles non relationnels). L'offre de Salesforce est en effet une véritable base de données relationnelle géante, telle que les connaissent et les maîtrisent des millions d'administrateurs et de développeurs dans le monde, spécialement conçue pour la co-location, adaptable à la demande en temps réel et facturée à l'usage (en fonction du volume de données et du nombre de transactions et d'utilisateurs).

Petit bémol dans ce panorama, l'accès aux données est réalisé via un langage spécifique, baptisé SOQL ou via des services web ("REST"). Mais un partenariat avec Progress Software promet une conversion automatique des requêtes en langage SQL (le standard d'interrogation des bases de données). Un autre partenaire, Informatica, a quant à lui annoncé une solution de transfert des bases classiques vers Database.com. Autant de facteurs qui faciliteront la transition pour ceux qui se laisseront séduire.

Avec cette nouvelle offre, Salesforce renforce ses positions dans le nuage de "plate-forme" (PaaS, Platform as a Service), alors que l'entreprise reste surtout connue pour sa solution de CRM (Customer Relationship Management ou Gestion de la Relation Client) et ses efforts dans le SaaS.

Convaincre les clients d'héberger leurs données dans le cloud, dans un système en co-location risque d'être difficile et les adversaires de Salesforce ne manquent pas de souligner les risques de sécurité (Oracle en tête, alors que Database.com est construit sur son SGBD). Mais le spécialiste du cloud dispose d'atouts pour s'imposer, notamment à travers ses utilisateurs actuels, les 87 000 entreprises clientes de l'offre de CRM étant de fait aussi clientes de la base de données.

[Mis à jour le 13/12/2010 pour clarifier le positionnement de Database.com parmi les bases de données en cloud.]

A la différence de la plupart des solutions existantes, Database.com n'est ni une instance de SGBDR dans un nuage d'infrastructure (qu'il faut donc administrer), ni un système de stockage spécifique à l'architecture en cloud (avec leurs modèles non relationnels). L'offre de Salesforce est en effet une véritable base de données relationnelle géante, telle que les connaissent et les maîtrisent des millions d'administrateurs et de développeurs dans le monde, spécialement conçue pour la co-location, adaptable à la demande en temps réel et facturée à l'usage (en fonction du volume de données et du nombre de transactions et d'utilisateurs).

Petit bémol dans ce panorama, l'accès aux données est réalisé via un langage spécifique, baptisé SOQL ou via des services web ("REST"). Mais un partenariat avec Progress Software promet une conversion automatique des requêtes en langage SQL (le standard d'interrogation des bases de données). Un autre partenaire, Informatica, a quant à lui annoncé une solution de transfert des bases classiques vers Database.com. Autant de facteurs qui faciliteront la transition pour ceux qui se laisseront séduire.

Avec cette nouvelle offre, Salesforce renforce ses positions dans le nuage de "plate-forme" (PaaS, Platform as a Service), alors que l'entreprise reste surtout connue pour sa solution de CRM (Customer Relationship Management ou Gestion de la Relation Client) et ses efforts dans le SaaS.

Convaincre les clients d'héberger leurs données dans le cloud, dans un système en co-location risque d'être difficile et les adversaires de Salesforce ne manquent pas de souligner les risques de sécurité (Oracle en tête, alors que Database.com est construit sur son SGBD). Mais le spécialiste du cloud dispose d'atouts pour s'imposer, notamment à travers ses utilisateurs actuels, les 87 000 entreprises clientes de l'offre de CRM étant de fait aussi clientes de la base de données.

[Mis à jour le 13/12/2010 pour clarifier le positionnement de Database.com parmi les bases de données en cloud.]

Greenpeace classe les entreprises technologiques

Greenpeace a publié la quatrième version de son "Cool IT Leaderboard", dans lequel l'association évalue et compare les actions et la politique en faveur de l'environnement des 17 plus grandes entreprises de technologies mondiales. En tête du classement, et seules à obtenir la moyenne, figurent dans l'ordre Cisco, Ericsson et Fujitsu alors que ce sont Oracle, Panasonic et SAP qui occupent le (très) bas de tableau.

Chaque entreprise est notée sur plusieurs critères répartis en 3 catégories : leurs efforts pour produire des solutions technologiques favorisant la réduction des émissions de gaz à effet de serre (GES), leurs initiatives pour réduire leur propre empreinte environnementale et, plus subjectif, leur engagement "politique".

Chaque entreprise est notée sur plusieurs critères répartis en 3 catégories : leurs efforts pour produire des solutions technologiques favorisant la réduction des émissions de gaz à effet de serre (GES), leurs initiatives pour réduire leur propre empreinte environnementale et, plus subjectif, leur engagement "politique".

Greenpeace réserve la plus grande importance à la première catégorie, considérant que les technologies de l'information et de la communication offrent une capacité de réduire de 15% les émissions globales de GES. Dans ce domaine, Cisco, Fujitsu et Ericsson mènent la charge non seulement par les solutions qu'elles proposent mais également par leurs priorités de développement placées sur celles-ci.

Pour ce qui concerne les émissions propres des entreprises évaluées, c'est IBM qui recueille la meilleure note, suivie de près par Cisco, qui ont toutes les deux une véritable politique de réduction, qui ne s'appuie pas prioritairement sur des actions de compensation. Les efforts de Google, avec ses récents investissements dans l'énergie éolienne, sont bien notés mais Greenpeace juge inacceptable que le géant Internet ne publie pas son empreinte environnementale et n'ait pas établi de cible de réduction.

Côté engagement politique, Google prend la tête du classement, devant Cisco et Ericsson, grâce à ses actions concrètes en faveur de l'environnement (par exemple, son support pour une loi californienne contre le réchauffement climatique). Greenpeace indique que les notes ont globalement baissé depuis la version précédente de son évaluation, qui coïncidait avec le sommet de Copenhague (et une forte implication des entreprises technologiques lors de cet événement).

Enfin, il faut bien revenir sur le cas d'Oracle, qui recueille un score de 12 points sur 100 (Cisco en obtenant 70, pour comparaison) à son arrivée dans le classement, correspondant aux plus mauvaises notes (ou presque) sur l'ensemble des critères retenus. Et le cas de SAP n'est pas beaucoup plus brillant... Greenpeace note d'ailleurs que les écarts se creusent entre les meilleurs et les pires élèves.

Pourquoi parler de ce classement ici ? Parce que les actions technologiques en faveur de l'environnement relèvent toujours (malheureusement) de l'innovation et qu'il me semble important de mettre en avant les meilleurs exemples en la matière. Lorsque Cisco développe des outils collaboratifs pour réduire les déplacements des collaborateurs ou quand IBM rationalise et consolide ses centres de production informatique pour limiter sa consommation électrique, elles prouvent à leurs clients que ces approches sont possibles et en valent la peine.

De plus, pour les entreprises qui s'engagent dans la réduction de leurs émissions de GES, la sélection de fournisseurs "responsables" est une des actions à leur disposition. Le classement de Greenpeace peut les aider à faire les "bons choix".

Pour ce qui concerne les émissions propres des entreprises évaluées, c'est IBM qui recueille la meilleure note, suivie de près par Cisco, qui ont toutes les deux une véritable politique de réduction, qui ne s'appuie pas prioritairement sur des actions de compensation. Les efforts de Google, avec ses récents investissements dans l'énergie éolienne, sont bien notés mais Greenpeace juge inacceptable que le géant Internet ne publie pas son empreinte environnementale et n'ait pas établi de cible de réduction.

Côté engagement politique, Google prend la tête du classement, devant Cisco et Ericsson, grâce à ses actions concrètes en faveur de l'environnement (par exemple, son support pour une loi californienne contre le réchauffement climatique). Greenpeace indique que les notes ont globalement baissé depuis la version précédente de son évaluation, qui coïncidait avec le sommet de Copenhague (et une forte implication des entreprises technologiques lors de cet événement).

Enfin, il faut bien revenir sur le cas d'Oracle, qui recueille un score de 12 points sur 100 (Cisco en obtenant 70, pour comparaison) à son arrivée dans le classement, correspondant aux plus mauvaises notes (ou presque) sur l'ensemble des critères retenus. Et le cas de SAP n'est pas beaucoup plus brillant... Greenpeace note d'ailleurs que les écarts se creusent entre les meilleurs et les pires élèves.

Pourquoi parler de ce classement ici ? Parce que les actions technologiques en faveur de l'environnement relèvent toujours (malheureusement) de l'innovation et qu'il me semble important de mettre en avant les meilleurs exemples en la matière. Lorsque Cisco développe des outils collaboratifs pour réduire les déplacements des collaborateurs ou quand IBM rationalise et consolide ses centres de production informatique pour limiter sa consommation électrique, elles prouvent à leurs clients que ces approches sont possibles et en valent la peine.

De plus, pour les entreprises qui s'engagent dans la réduction de leurs émissions de GES, la sélection de fournisseurs "responsables" est une des actions à leur disposition. Le classement de Greenpeace peut les aider à faire les "bons choix".

Etude iPass : émergence de la "mobilocratie"

Le spécialiste des solutions mobiles pour entreprise iPass présente [lien PDF] un état des lieux des usages professionnels du mobile et délivre ses prédictions pour 2011, dont la principale est l'avènement d'une "mobilocratie" dominante.

Le rapport, établi sur la base d'une enquête auprès de 4000 utilisateurs des services d'iPass et d'une analyse de 30 millions de sessions, présente les 5 principales tendances observées en 2010 et propose 5 prédictions majeures pour l'année qui vient.

Tendances 2010

Le rapport, établi sur la base d'une enquête auprès de 4000 utilisateurs des services d'iPass et d'une analyse de 30 millions de sessions, présente les 5 principales tendances observées en 2010 et propose 5 prédictions majeures pour l'année qui vient.

Tendances 2010