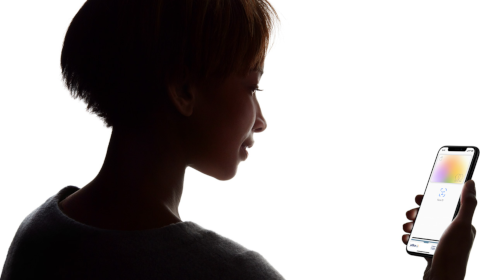

Il a suffi d'un tweet (ou deux) pour enflammer les réseaux sociaux, lancer une vague d'indignation dans la presse… et même déclencher une enquête officielle ! Pourtant, les accusations de discrimination à l'encontre de la carte de crédit d'Apple n'ont probablement aucun fondement, même si des erreurs ont réellement été commises.

Bien sûr, au premier abord, la révélation a de quoi scandaliser : dans un couple dont les finances sont entièrement partagées, l'homme obtient un plafond de crédit 20 fois supérieur à celui de sa compagne ! Voilà un exemple de sexisme insupportable, n'est-ce pas ? Et bien non. En réalité, quelle que soit l'énormité des faits, rien ne permet de soutenir une telle hypothèse, qui supposerait une faute extraordinairement improbable de la part d'Apple ou de Goldman Sachs (l'émetteur de la carte).

La loi est très claire dans la plupart des pays développés (dont les États-Unis) quand elle affirme expressément que les consommateurs doivent être traités de manière identique quel que soit leur sexe (et cette règle est souvent applicable à d'autres facteurs, ethniques par exemple). En conséquence, les entreprises qui exploitent des algorithmes pour prendre des décisions sont contraintes d'écarter ces critères de leurs modèles et il est quasiment inimaginable que le calcul du score de crédit de la carte Apple y ait dérogé.

En revanche, l'anomalie constatée peut avoir une multitude d'autres causes. Ainsi, chaque demande de souscription étant traitée individuellement, elle peut être due, par exemple, à des informations incomplètes fournies lors du dépôt du dossier et/ou à des anomalies dans les logiciels d'analyse – qui ne seraient pas totalement surprenantes de la part de novices du secteur (Godlman Sachs n'ayant pas d'expérience en la matière) – sans que celles-ci ne soient directement liées au sexe du (ou de la) client(e).

Bien sûr, au premier abord, la révélation a de quoi scandaliser : dans un couple dont les finances sont entièrement partagées, l'homme obtient un plafond de crédit 20 fois supérieur à celui de sa compagne ! Voilà un exemple de sexisme insupportable, n'est-ce pas ? Et bien non. En réalité, quelle que soit l'énormité des faits, rien ne permet de soutenir une telle hypothèse, qui supposerait une faute extraordinairement improbable de la part d'Apple ou de Goldman Sachs (l'émetteur de la carte).

La loi est très claire dans la plupart des pays développés (dont les États-Unis) quand elle affirme expressément que les consommateurs doivent être traités de manière identique quel que soit leur sexe (et cette règle est souvent applicable à d'autres facteurs, ethniques par exemple). En conséquence, les entreprises qui exploitent des algorithmes pour prendre des décisions sont contraintes d'écarter ces critères de leurs modèles et il est quasiment inimaginable que le calcul du score de crédit de la carte Apple y ait dérogé.

En revanche, l'anomalie constatée peut avoir une multitude d'autres causes. Ainsi, chaque demande de souscription étant traitée individuellement, elle peut être due, par exemple, à des informations incomplètes fournies lors du dépôt du dossier et/ou à des anomalies dans les logiciels d'analyse – qui ne seraient pas totalement surprenantes de la part de novices du secteur (Godlman Sachs n'ayant pas d'expérience en la matière) – sans que celles-ci ne soient directement liées au sexe du (ou de la) client(e).

Le cas en question permet de s'arrêter un instant sur les idées fausses qui circulent allègrement sur les algorithmes et leurs failles supposées, puis, au-delà, sur les difficultés de concilier traitements des données et équité. En effet, il s'avère, d'après une étude scientifique [PDF] très sérieuse, que les femmes seraient avantagées si le sexe était pris en compte dans les décisions d'attribution d'un crédit (automobile, en l'occurrence), simplement parce qu'elles sont statistiquement moins sujettes à faire défaut.

La perception publique des biais de l'analyse de données est donc fondamentalement contredite par l'expérience. Malheureusement, l'absence d'explication immédiate – les opérateurs du support d'Apple n'ayant d'autre réponse que d'incriminer le logiciel – à ce qui ressort comme une injustice laisse libre cours à tous les fantasmes, susceptibles d'engendrer des conséquences graves pour les entreprises. Seule une transparence totale sur les mécanismes mis en œuvre pourra éviter la défiance généralisée.

Il restera ensuite à nous pencher, avec Galina Andreeva [PDF], sur la pertinence de notre approche traditionnelle de la lutte contre les discriminations. Faut-il maintenir des protections assurant l'égalité ou l'équité ? Faut-il focaliser l'attention sur les traitements ou sur leurs résultats ? Et comment tous ces aspects pourront-ils être effectivement contrôlés avec la propagation de l'intelligence artificielle dans notre vie quotidienne ?

La perception publique des biais de l'analyse de données est donc fondamentalement contredite par l'expérience. Malheureusement, l'absence d'explication immédiate – les opérateurs du support d'Apple n'ayant d'autre réponse que d'incriminer le logiciel – à ce qui ressort comme une injustice laisse libre cours à tous les fantasmes, susceptibles d'engendrer des conséquences graves pour les entreprises. Seule une transparence totale sur les mécanismes mis en œuvre pourra éviter la défiance généralisée.

Il restera ensuite à nous pencher, avec Galina Andreeva [PDF], sur la pertinence de notre approche traditionnelle de la lutte contre les discriminations. Faut-il maintenir des protections assurant l'égalité ou l'équité ? Faut-il focaliser l'attention sur les traitements ou sur leurs résultats ? Et comment tous ces aspects pourront-ils être effectivement contrôlés avec la propagation de l'intelligence artificielle dans notre vie quotidienne ?

Aucun commentaire:

Enregistrer un commentaire

Afin de lutter contre le spam, les commentaires ne sont ouverts qu'aux personnes identifiées et sont soumis à modération (je suis sincèrement désolé pour le désagrément causé…)